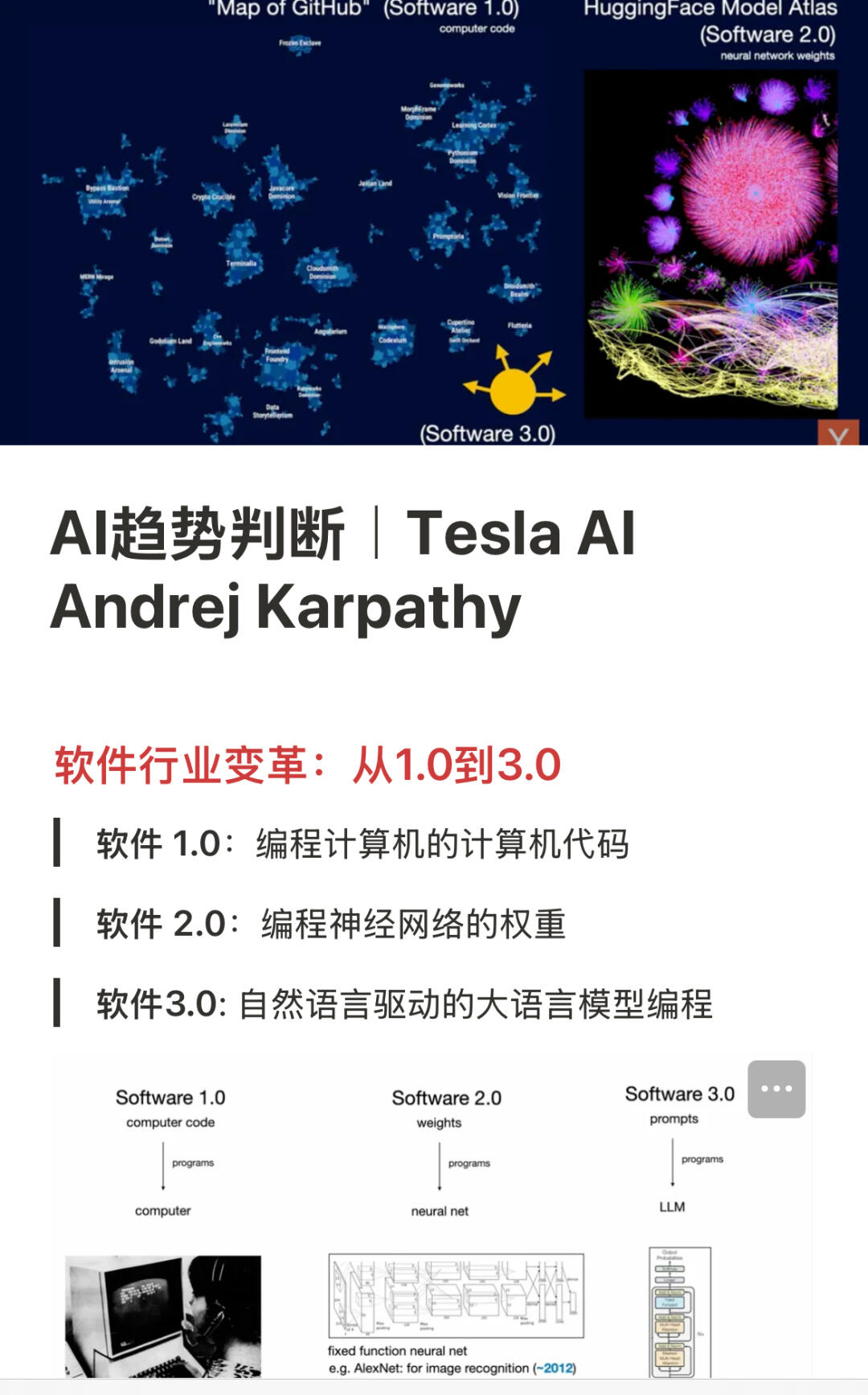

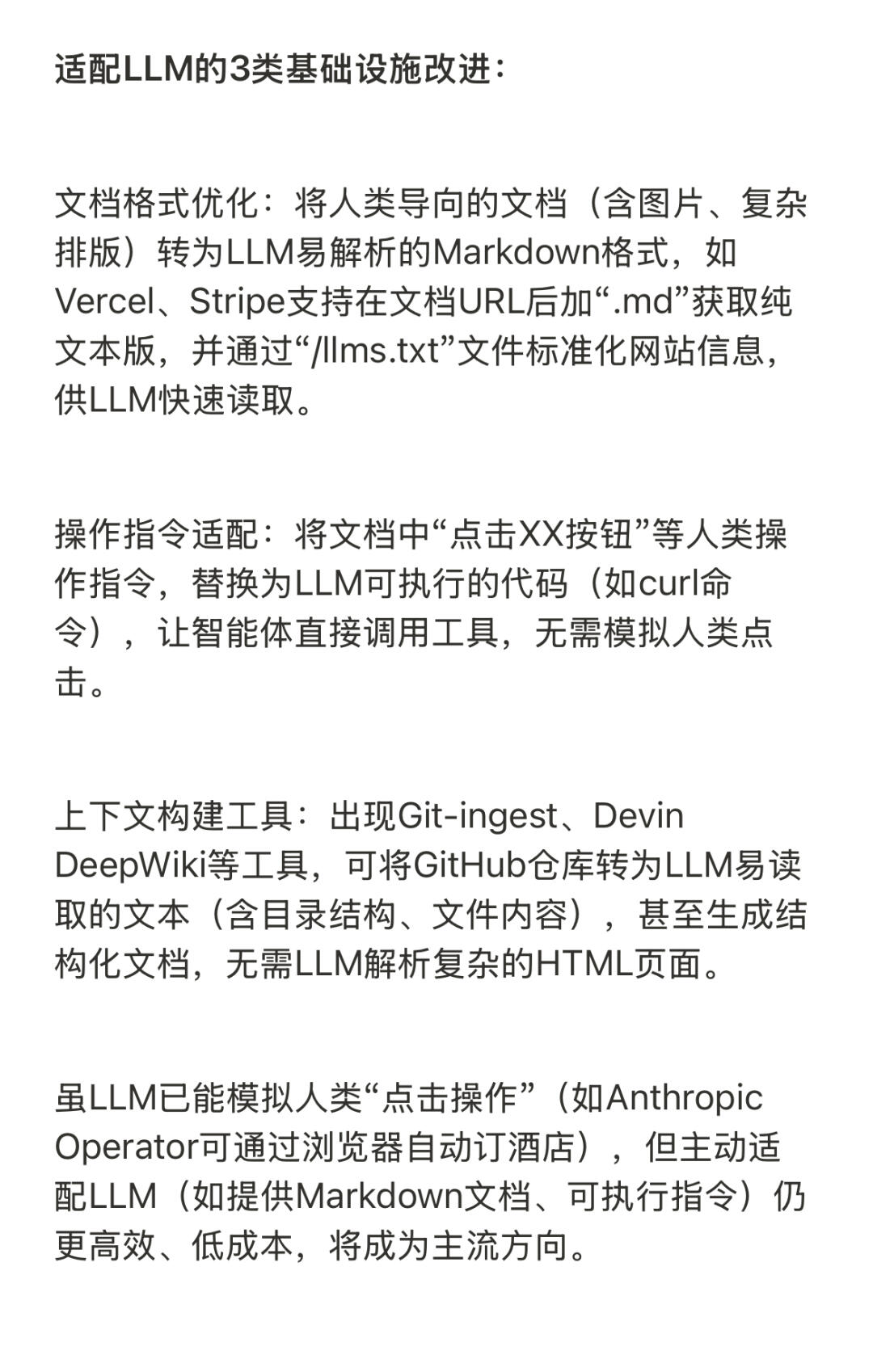

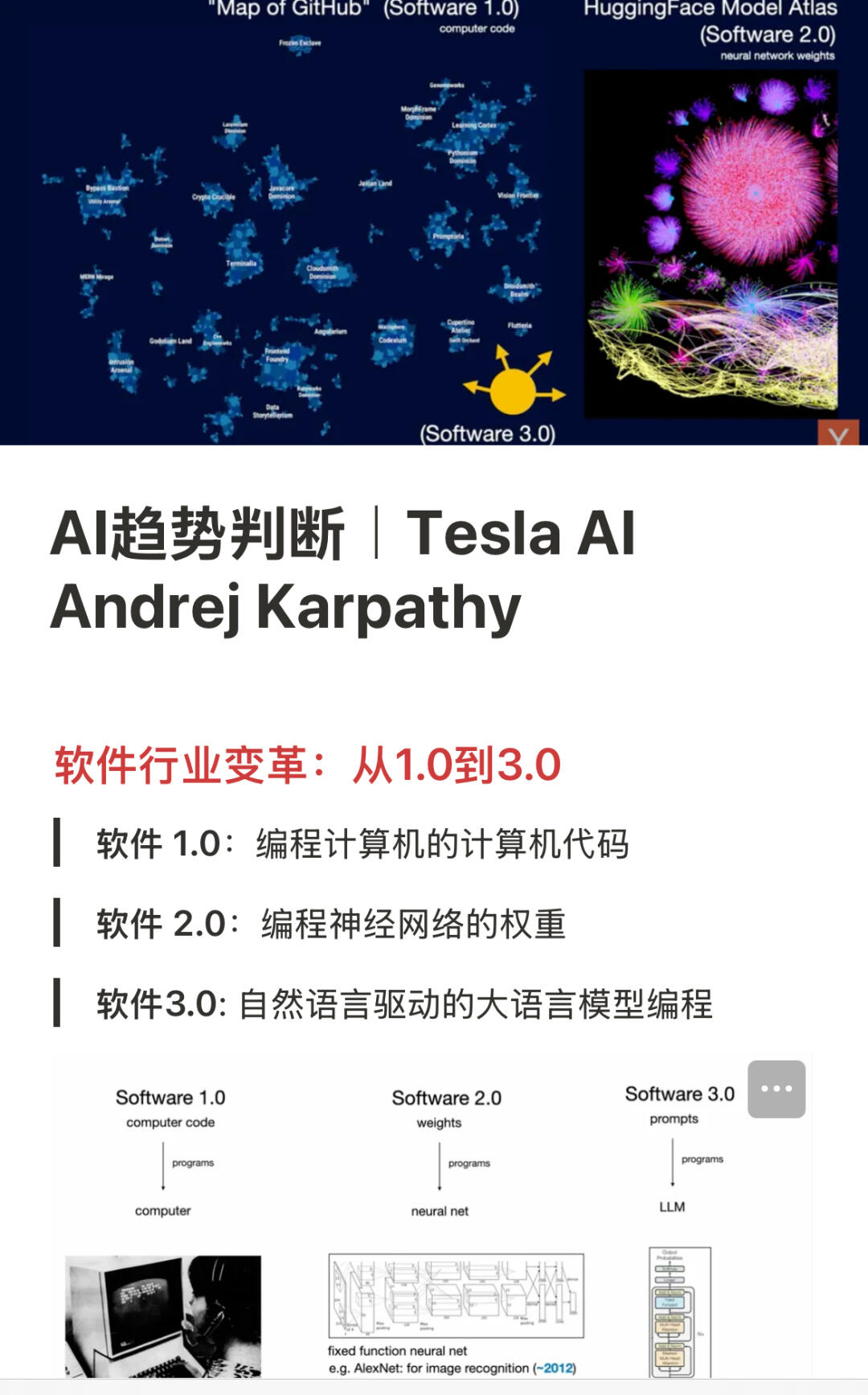

▪️软件行业变革:从1.0到3.0

> 软件 1.0:编程计算机的计算机代码

> 软件 2.0:编程神经网络的权重

> 软件 3.0: 自然语言驱动的大语言模型编程

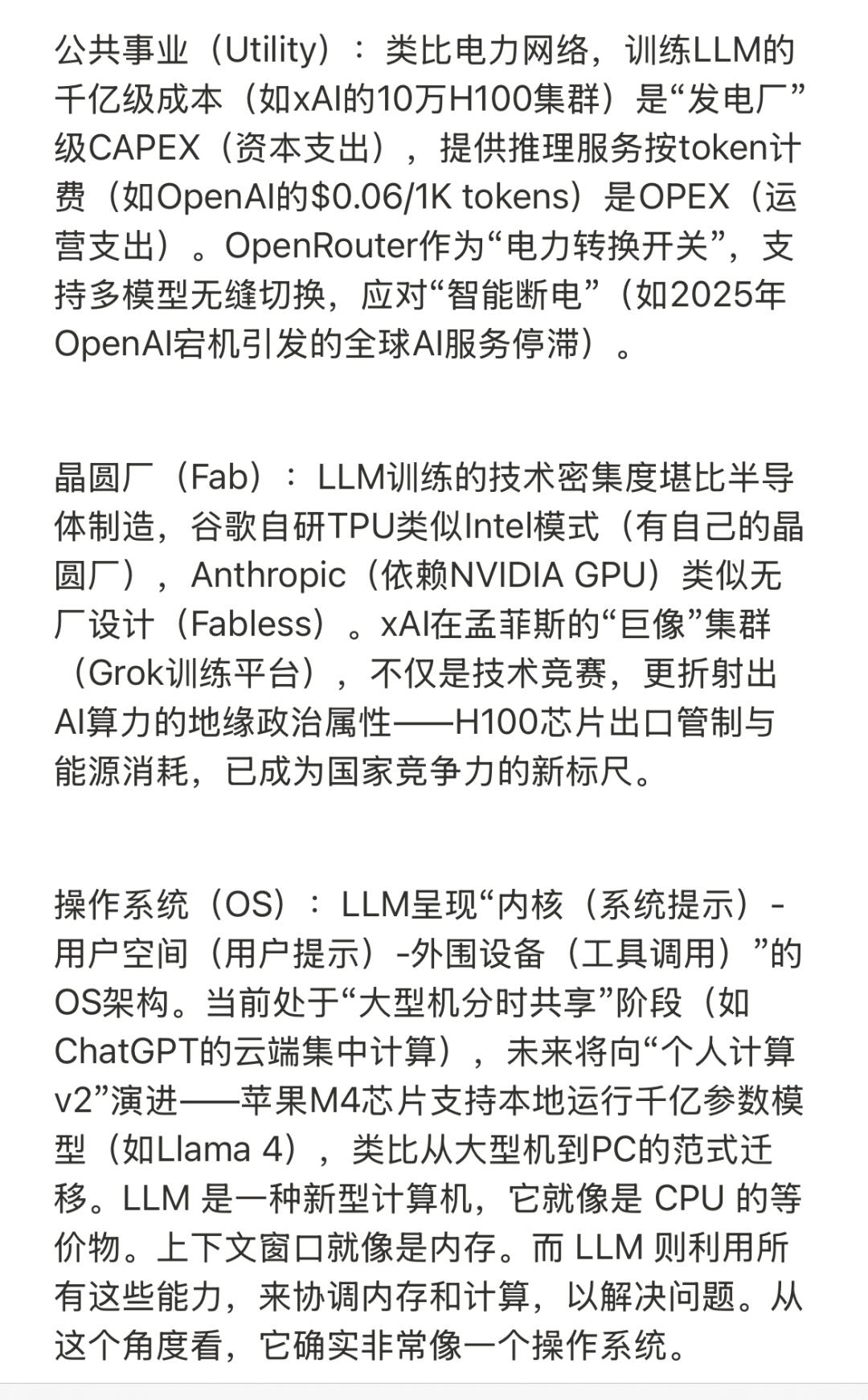

软件1.0:以人类编写的显式代码(如Python、C++)为核心,开发依赖算法思维与语言语法,运行于CPU,典型代表是GitHub上的传统代码仓库。

软件2.0:核心产物是神经网络权重,通过策划数据集、训练模型生成,需数据科学与机器学习技能,依赖GPU/TPU,代表平台是Hugging Face,典型案例是特斯拉Autopilot的BEV Net神经网络,取代传统百万行代码处理驾驶边缘场景。

软件3.0:以自然语言提示词为核心,基于预训练LLM实现任务,只需提示工程与领域知识,运行于LLM服务/设备端,核心特点是“用英语编程”,大幅降低开发门槛。

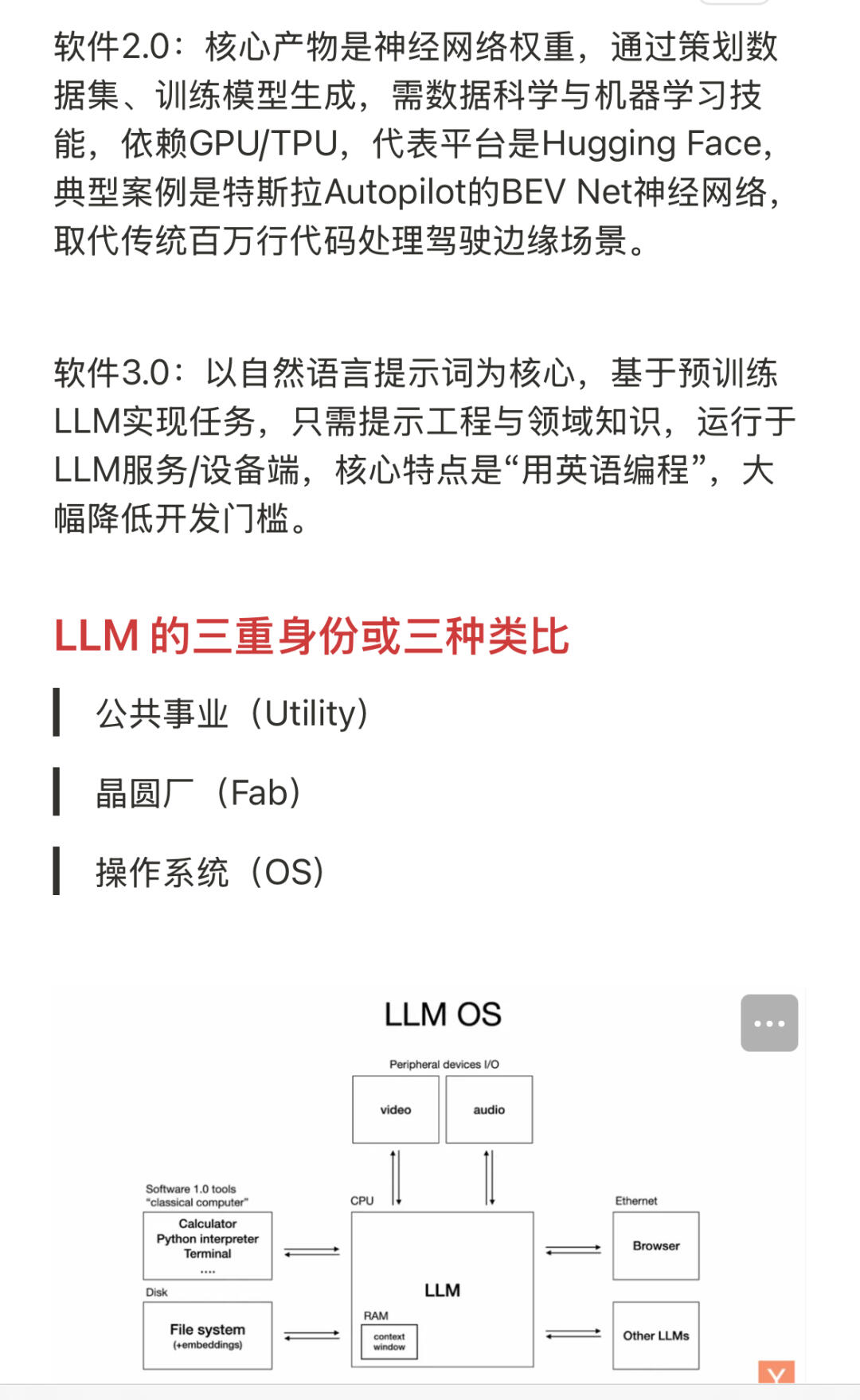

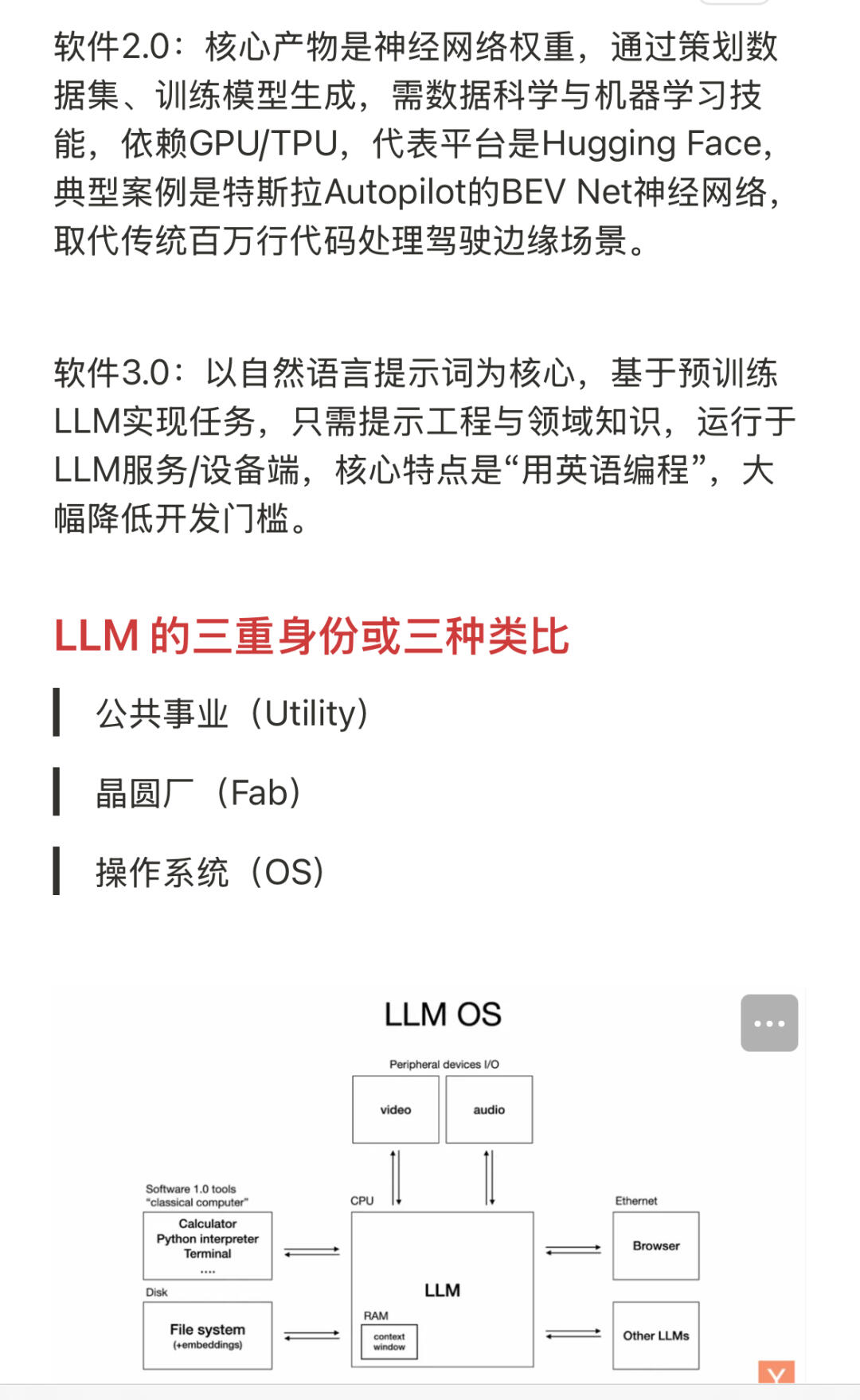

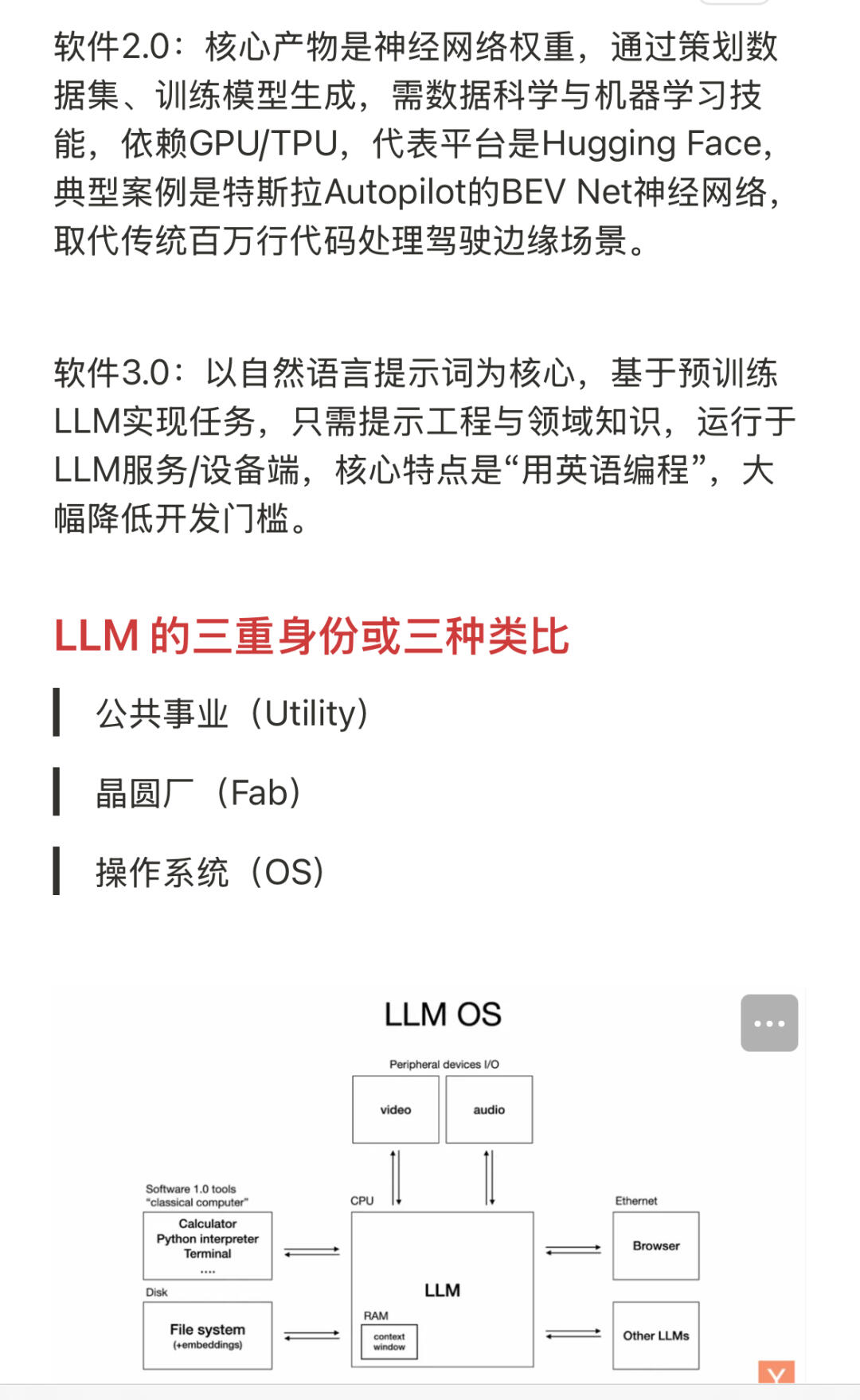

▪️LLM 的三重身份或类比

> 公共事业(Utility)

> 晶圆厂(Fab)

> 操作系统(OS)

公共事业(Utility):类比电力,训练LLM的千亿级成本(如xAI的10万H100集群)是“发电厂”级CAPEX(资本支出),提供推理服务按token计费(如OpenAI的$0.06/1K tokens)是OPEX(运营支出)。OpenRouter作为“电力转换开关”,支持多模型无缝切换,应对“智能断电”。

晶圆厂(Fab):LLM训练的技术密集度堪比半导体制造,谷歌自研TPU类似Intel模式(有自己的晶圆厂),Anthropic(依赖NVIDIA GPU)类似无厂设计。xAI在孟菲斯的“巨像”集群(Grok训练平台),不仅是技术竞赛,更折射出AI算力的地缘政治属性。

操作系统(OS):LLM呈现“内核(系统提示)-用户空间(用户提示)-外围设备(工具调用)”的OS架构。当前处于“大型机分时共享”阶段,未来将向“个人计算v2”演进——苹果M4芯片支持本地运行千亿参数模型(如Llama 4),类比从大型机到PC的范式迁移。LLM 是一种新型计算机,它就像是 CPU 的等价物。上下文窗口就像是内存。而 LLM 则利用所有这些能力,来协调内存和计算,以解决问题。