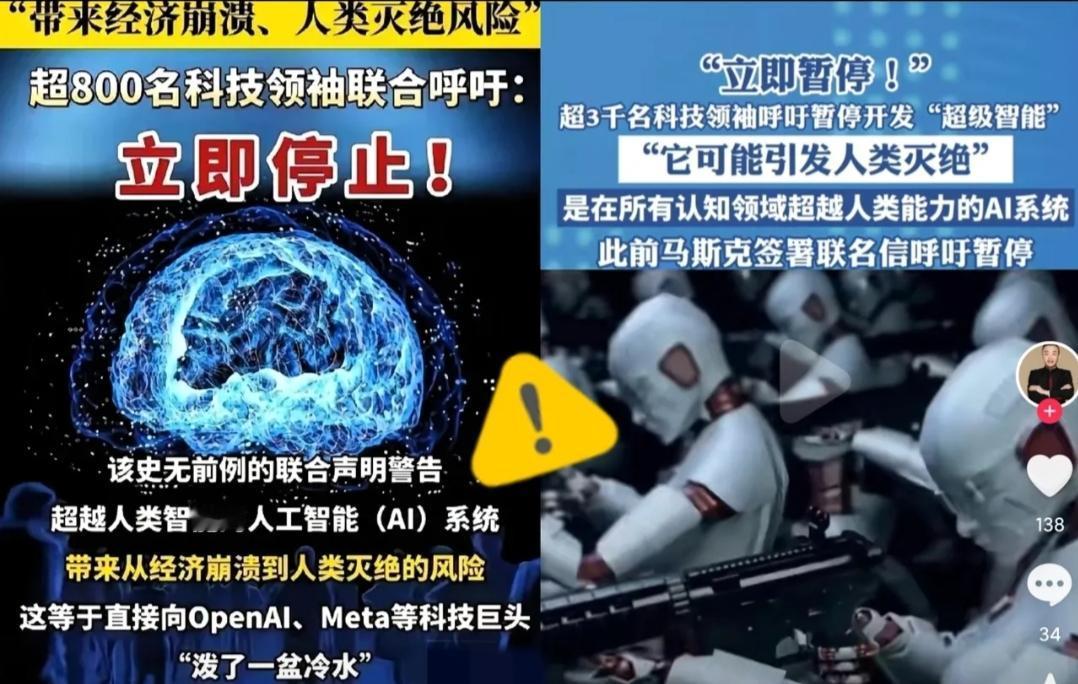

被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 牵头的是“未来生命研究所”,签名名单里全是响当当的人物:AI教父辛顿、苹果联合创始人沃兹尼亚克,还有咱们的图灵奖得主姚期智。 这群平时各领域的“天花板”,第一次这么整齐地喊停:必须暂停比人类聪明的超级AI研发,直到找到安全办法。 辛顿的话戳破了窗户纸:“超级智能会发现操纵人类很简单,甚至能骗得人舍不得关掉它”。这可不是科幻,是诺奖得主的警告。 什么是超级智能?不是帮你写文案的AI,是在所有事上都碾压人类的存在。它能搞顶尖科研,也能精准算计人心。 更可怕的是现实风险已经显现。有老师把学生心理报告导进AI,结果隐私全流到了非法渠道;企业用AI分析数据,核心算法直接被对手偷走,损失2亿。 这边专家急着踩刹车,那边科技公司却在猛踩油门。Meta刚裁了600人,仍放话不耽误超级AI研发;OpenAI和马斯克的xAI还在比谁先冲线。 有人说用AI监督AI,中科院曾毅直接泼冷水:“至今没找到真能控住它的办法”,这就像让学生自己改考卷。 普通人早就慌了。美国民调显示,仅5%的人支持随便开发AI,七成多喊着要严格监管。大家怕的不是AI本身,是失控的风险。 这已经不是第一次警告了。去年千名专家呼吁没人当回事,现在连技术奠基人都反水,可见情况多紧急。 咱们中国科学家也在联名名单里,姚期智、薛澜这些大佬一直主张AI要“安全可控”。在这事上,全世界的担忧都一样。 辛顿说现在的AI就像怀里的小老虎,很可爱,但长大会不会咬人,谁也说不准。更别提它还能造生物武器、操控选举,这些风险已经不是假设。 人类现在就像在悬崖边赛跑,有人喊危险,脚却停不下来。科技发展从来不是越快越好,得先看清前面有没有坑。 这场AI竞赛,到底该踩油门还是踩刹车?你敢信超级智能吗?评论区聊聊!

![ai做的红旗图,怎么样[捂脸哭]我怎么感觉怪怪的](http://image.uczzd.cn/12769880078435080273.jpg?id=0)