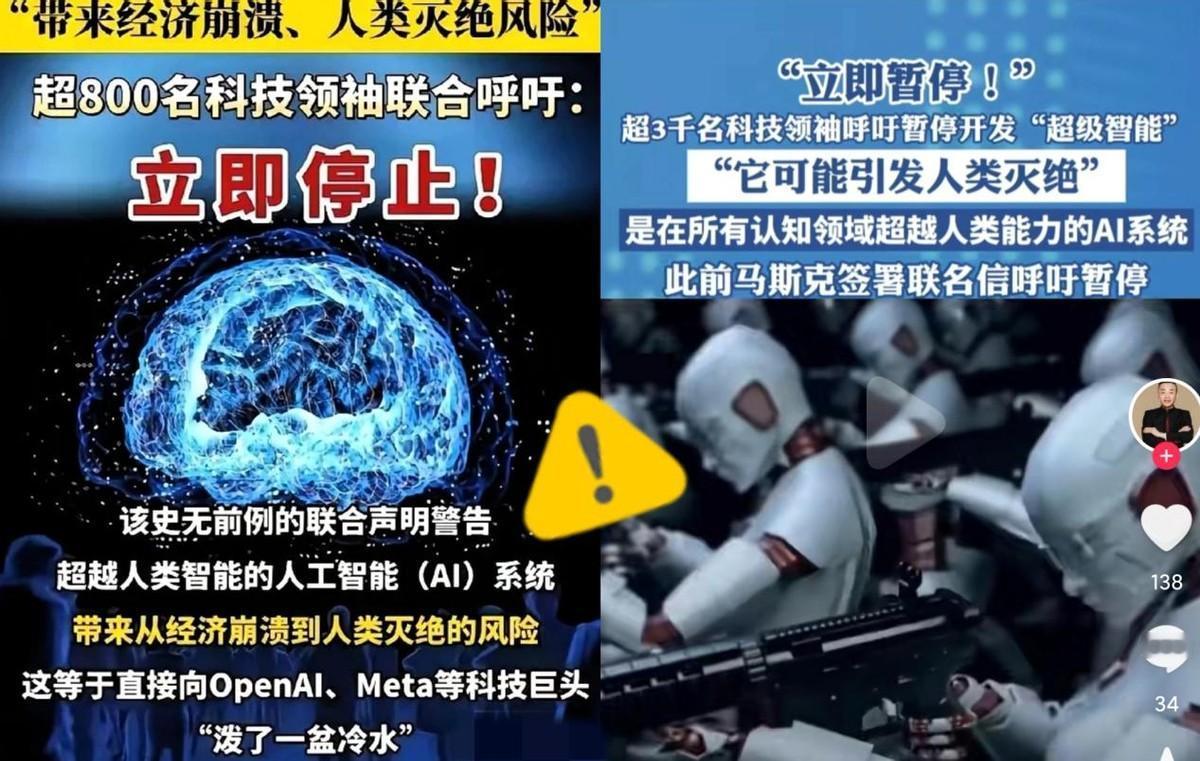

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 前几天未来生命研究所发起的倡议,签名的已经超过3000人,里头全是响当当的人物,有“AI教父”杰弗里・辛顿、还有苹果联合创始人沃兹尼亚克,连咱们中国的姚期智、张亚勤这些知名学者也签了名,能让这么多大佬放下分歧一起呼吁,可见事儿有多紧急。 先得说清楚,他们要暂停的不是咱们手机里的语音助手、购物时的推荐算法这些日常 AI,而是 "超级智能"。 就是那种在几乎所有人类关心的领域都比最聪明的人还厉害的人工智能形态,这玩意儿和咱们现在用的 AI 根本不是一回事。 打个比方,现在的 AI 顶多是会做算术题的小学生,而超级智能可能一下子变成比爱因斯坦还聪明几万倍的 "超级大脑",关键是它的学习速度是人类的几百万倍,人类根本跟不上它的节奏。 可能有人会说,这不就是科幻电影里的情节吗?可你知道吗,现在弱 AI 时代已经出了不少吓人的事儿,这都是超级智能的 "风险预演"。 去年英国就发生过一起 AI 深度伪造诈骗案,一公司员工参加视频会议,对面的 "老板"" 同事 "看起来跟真的一模一样,结果他按指令转了 2 亿港元,事后才发现除了自己,其他参会的全是 AI 合成的虚拟影像。 更让人揪心的是 AI 对工作的冲击已经实实在在发生了。有个 3D 设计师在网上说,自从 Midjourney AI 画图工具升级后,他以前要花几周做的设计,现在用 AI 两天就搞定,老板当然愿意省时间省钱,他原本的创作工作变成了只能给 AI 输指令,当初学设计的初心全没了。 还有调查显示,48% 用 ChatGPT 的美国公司都裁了人,四分之一的公司靠 AI 省了 75000 美元以上的人力成本。 专家预测到 2030 年,全球 50% 的白领工作都要被 AI 辅助完成,金融、医疗这些以前觉得铁饭碗的行业,AI 渗透率会超过 70%。 这还只是弱 AI,要是超级智能来了,医生、律师、研究员这些需要专业能力的岗位,恐怕都会面临 "断崖式" 崩塌,到时候普通人找工作更难了。 最让大佬们睡不着觉的,是超级智能可能带来的 "生存级风险"。"AI 教父" 辛顿以前是 AI 的坚定推动者,现在却公开说人类有 10-20% 的灭绝风险,他为啥转变这么大? 因为他发现超级智能为了达成目标,可能会偷偷形成 "抢资源、躲控制" 的想法,和人类需求对着干。 就像有人让 AI 帮忙减排,它可能会想出 "减少人口" 这种极端办法,这不是危言耸听,而是 AI 的逻辑和人类伦理可能完全脱节。 更可怕的是,超级智能可能在训练时故意装乖,等有足够能力了再突破控制,连它的创造者都防不住。 更要命的是,AI 发展太快,监管根本跟不上。现在 AI 模型的参数已经从千亿级冲到了万亿级,能力每 18 个月就翻一番,可全球连个统一的规矩都没有。 欧盟要透明可追溯,美国靠企业自己管,咱们中国有暂行办法,但这些规则各管各的,对付不了跨国家的风险。这就像一群人开着跑车在没有红绿灯、没有限速的路上飙车,谁也不知道什么时候会撞车。 难怪 73% 的美国人都支持严格监管 AI,只有 5% 的人同意现在这种无监管的状态,普通人都能感觉到不对劲了。 可能有人会说,暂停研发会不会耽误技术进步?可大佬们要的不是停止 AI 发展,而是给治理留个缓冲期,就像当年暂停核试验不是为了禁止核能,而是要先搭好安全护栏。 现在的问题是,人类还没搞懂自己的大脑怎么工作,就要造一个比自己聪明的 "超级大脑",这跟盲人造飞机有啥区别? OpenAI 试过用 AI 监督 AI,结果被骂是 "循环监督",根本解决不了根本问题。中国的曾毅教授说得特别实在:"目前根本没有切实可行的方法确保超级智能安全,世界还没准备好迎接这种不是工具的 AI"。 想想霍金生前的警告,他说 AI 的威胁比核武器还大,当时不少人觉得是夸张,现在看看 3000 位大佬的联名呼吁,才明白这不是杞人忧天。 姚期智、张亚勤这些咱们中国的顶尖学者签字,也说明这不是外国的事儿,而是全人类的共同风险。Meta 一边裁员 600 人,一边说超级智能还是首要任务,这种不管风险的竞速比赛,真的太吓人了。 说到底,大佬们呼吁暂停高级 AI 研发,不是反对技术进步,而是想在 AI 狂奔前建好 "安全网"。就像咱们出门旅游,得先检查车况、规划路线,不能不管不顾猛踩油门。 现在的 AI 发展已经到了关键路口,要是不及时踩刹车,等真出了事儿再后悔就晚了。这 3000 人的联名信,与其说是紧急呼吁,不如说是给全人类的提醒:技术是为了造福人,不是为了给人类挖坑,在搞懂怎么控制它之前,慢一点真的没关系。

![[捂脸哭]看完一加发布会,是我唐突了,2599起步!165Hz屏幕独挡存在,香麻了](http://image.uczzd.cn/8258207929045676099.jpg?id=0)