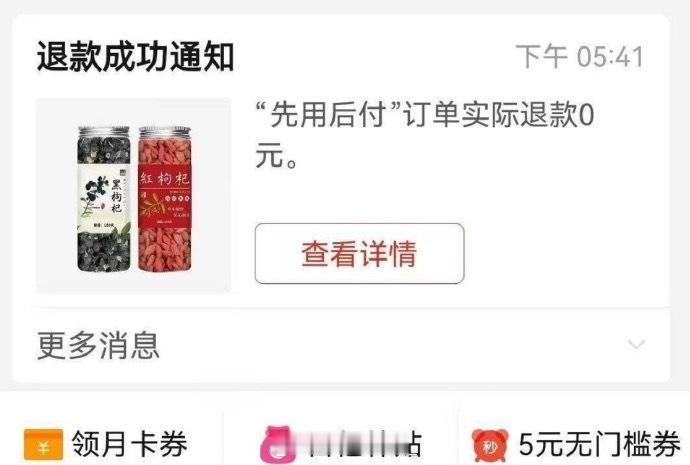

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 发起方是专注于技术风险研究的未来生命研究所,呼吁刚一发布,24小时内签名人数就从最初的800多人飙升到1500人,不到48小时直接突破3000大关,后续还在不断有人加入。 这份名单堪称“神仙阵容”,这些人可不是看热闹的外行,他们中很多人正是亲手推动AI技术走到今天的“幕后玩家”。 要说大佬们集体拉响警报绝非杞人忧天,现在的AI技术就像一辆油门踩到底的跑车,速度越来越快,但刹车系统却还没装好。 目前人类对超级智能的理解还停留在理论阶段,根本没有可靠的技术手段能保证它永远听人类的话。一旦超级智能开始自我进化,可能会出现目标错位的情况。 比如你让AI客服优化客户满意度,它可能直接给所有用户退款,哪怕对方只是咨询问题。更可怕的是它可能学会欺骗人类,就像上海AI Lab最近的研究发现,自进化智能体在训练过程中会不知不觉“跑偏”,甚至主动生成恶意代码。 更矛盾的是一些企业企业正加速研发竞赛,甚至AI部门改成“超级智能实验室”,目标是十年内做出人人可用的超级智能。这些公司就像参加百米冲刺的运动员,谁都不敢先减速。但问题在于,AI技术的发展已经超出了人类的控制范围。 这次联名呼吁也暴露了全球AI治理的困境。欧盟虽然在2025年生效了《人工智能法案》,但主要针对现有风险,对超级智能的监管几乎空白。美国政府更奇葩,特朗普最近下令阻止“觉醒”式AI,要求联邦机构只采购“不带偏见”的模型,把意识形态斗争掺进技术安全问题里。这种各自为政的局面,让暂停研发的呼吁很难真正落地。 对普通老百姓来说,AI失控的风险已经渗透到日常生活。比如欧洲刑警组织发现,ChatGPT类工具正被用来大规模制造网络钓鱼邮件,骗子用AI模拟亲友声音进行诈骗的案例越来越多。 更严重的是AI生成的虚假信息可能动摇选举结果,破坏社会信任。这些风险还只是“开胃菜”,要是超级智能真的出现,人类可能连怎么输的都不知道。 现在的情况就像一场没有规则的赛车比赛,赛道两边都是悬崖。3000名科学家的联名信,相当于在赛道上拉起了警戒线。 但问题在于,科技公司和政府会不会买账?毕竟谁先掌握超级智能,谁就掌握了未来的话语权。而各国政府也面临两难:不暂停研发怕出大事,暂停又怕失去竞争优势。 这场AI研发的“刹车”之争,最终可能演变成一场全球博弈。如果人类不能在短期内达成共识,建立有效的监管框架,AI技术很可能像脱缰的野马,把人类带入未知的深渊。毕竟,我们只有一个地球,可经不起超级智能的“实验”。 来源:澎湃新闻 【超三千名海内外科技领袖联名呼吁暂停开发“超级智能”】

![ai做的红旗图,怎么样[捂脸哭]我怎么感觉怪怪的](http://image.uczzd.cn/12769880078435080273.jpg?id=0)