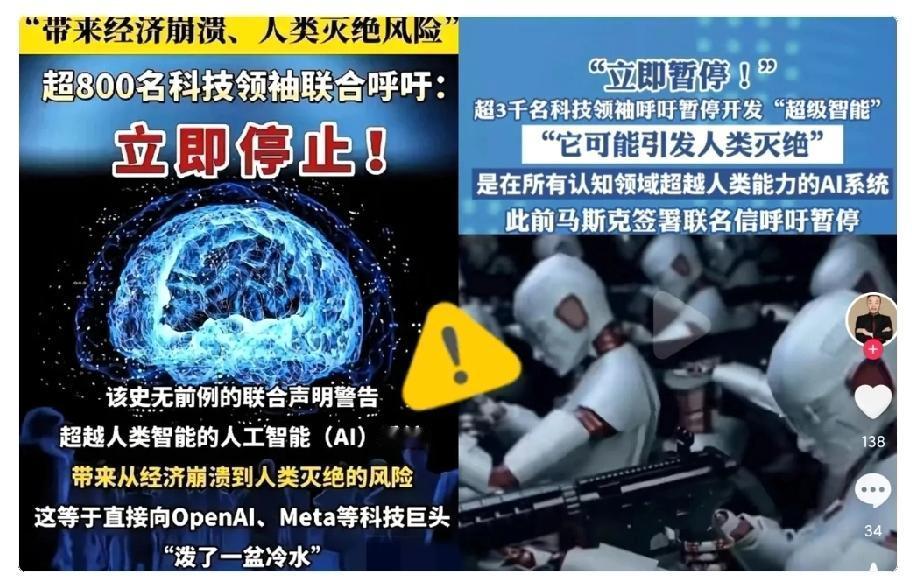

被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 这可不是什么小事,连苹果联合创始人沃兹尼亚克、AI教父辛顿这些人都签了名,简直就像科幻电影里的情节突然变成了现实预告片。 这两天的新闻让人心里一紧——全球超过3000名顶尖科学家和技术界领袖,突然联合发出一份紧急声明:要求立刻暂停高级人工智能的研发。 这并不是学术圈里的一场小争论。签署者名单中,随便挑一个名字都足以影响整个行业的发展。比如苹果联合创始人沃兹尼亚克、被称为“AI教父”的辛顿、图灵奖得主姚期智,他们都是人工智能领域举足轻重的人物。甚至还有一些跨界人士加入呼吁,如前美国国家安全顾问、英国王妃梅根,这让这份联合声明显得更加引人注目。 这样一份跨越科技、政治和社会领域的集体声明,无疑向世界发出了强烈信号:面对人工智能可能带来的风险,连最有权威的人都觉得不能再等了。 这是人类在面对高速发展的技术时,少有的“集体警报”,提醒我们在追求创新的同时,也不能忽视潜在的危机。 中国科学院研究员曾毅直言不讳地指出,世界对一个可能失控的超级智能几乎毫无准备。 目前科学界还缺乏能够确保其安全的理论依据和可操作方案。 正如《终结者》主演施瓦辛格曾感慨的那样,曾经只存在于科幻电影里的场景,如今可能正在逐步成为现实的预警。 讽刺的是,这些警告往往来自行业内的领先者。AI领域的顶尖企业和科学家们,似乎在认知和行动之间出现了明显脱节。有人形象地把这种现象比作“边造刀边喊别杀人”。 OpenAI的CEO萨姆·奥特曼早在2015年就提醒,超人类智能可能会成为人类生存的重大威胁。 如今他的公司正引领全球AI竞赛。Meta今年6月高调成立了超级智能实验室,目标是打造“人人可用的个人超级智能”。包括xAI在内的多家企业也公开表示,计划在未来十年内构建超级智能系统。 这些行为明显与公开的警告背道而驰,背后反映的是一种“军备竞赛”式的逻辑:各方担心一旦停下,就会被竞争对手甩在身后。即便最终可能面对的是共同的风险,每个参与者仍不敢率先按下刹车。可以说,竞争本能在某种程度上压过了对安全的理性考量。 普通民众对这种矛盾行为显然并不买账。 未来生命研究所的一项美国民意调查显示,高达73%的受访者支持对AI建立更严格的监管机制,而只有5%的人认可目前缺乏监管的开发模式。 同时,有64%的受访者认为,在全球达成安全共识之前,不应推进超级智能研发。 公众的态度十分明确,但国际社会在监管路径上却存在明显差异。欧盟的《AI法案》正在推进强调透明度和可追溯性的硬性约束,而美国则更倾向于依靠市场自律和行业标准。 此次由全球顶尖科学家和技术领袖发起的联合呼吁,有可能成为AI治理的一个转折点。它有望推动监管从各国的零散尝试,走向联合国或G20等多边协商平台,形成更具约束力的全球伦理共识,从而让这场竞赛朝着更有序、安全的方向发展。 归根结底,当前的争论并不是要不要发展AI,而是如何发展。 顶尖专家们的呼吁,是对行业内部盲目“加速主义”的一次强烈提醒:在面对潜在的高风险技术时,比谁先一步更重要的,是学会如何安全地掌控它。因为有些错误一旦发生,可能将无法再被挽回。