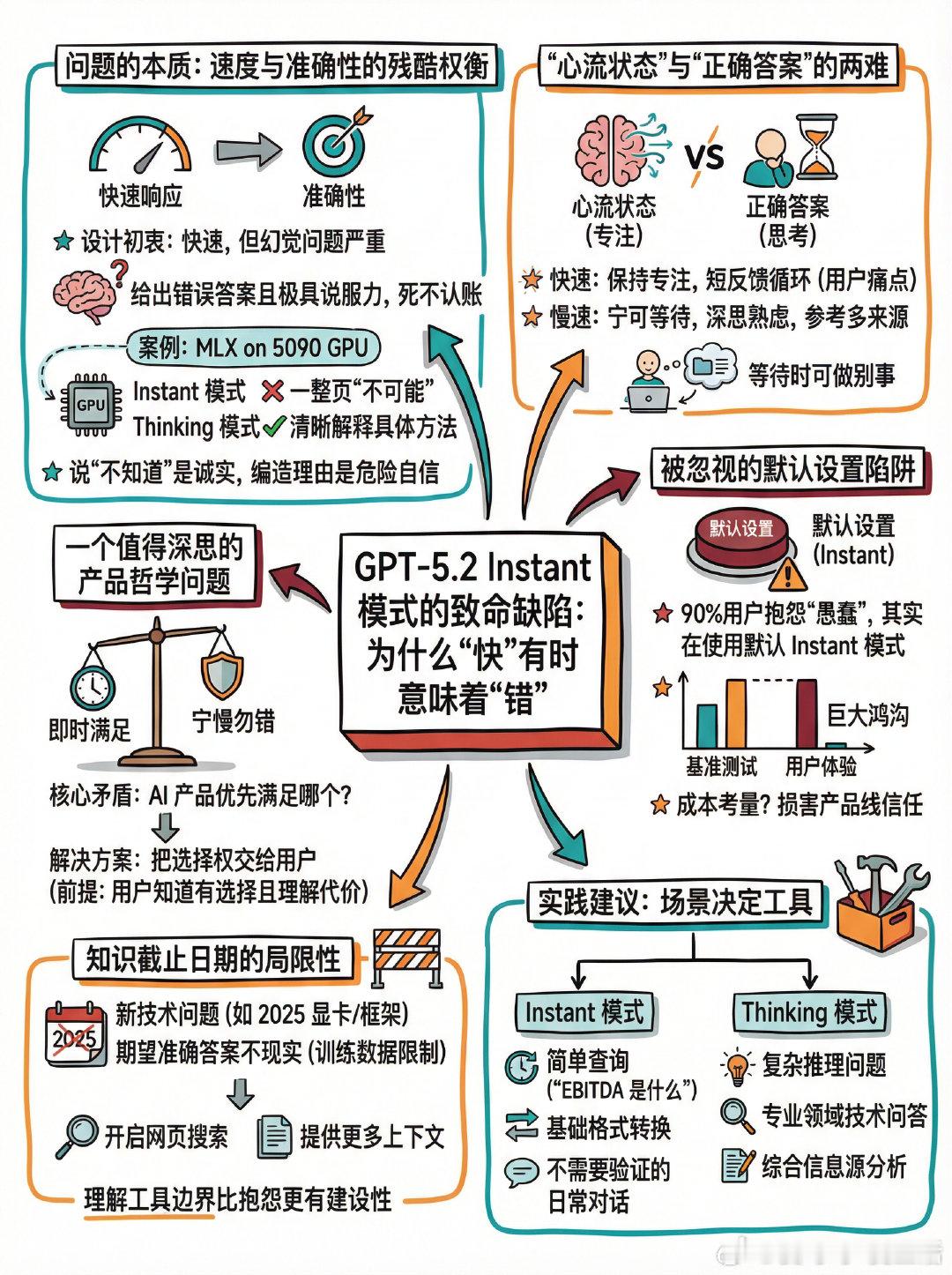

【GPT-5.2 Instant模式的致命缺陷:为什么“快”有时意味着“错”】一场关于AI模型选择的讨论正在Reddit上引发热议,核心观点直指要害:ChatGPT的5.2 Instant/Auto模式存在严重的幻觉问题,而且会对错误答案“死不认账”。+ 问题的本质:速度与准确性的残酷权衡Instant模式的设计初衷是快速响应,但用户反馈揭示了一个令人不安的现象——它不仅会给出错误答案,还会以极具说服力的方式呈现这些错误,甚至在被质疑时反复坚持。一位用户分享了一个典型案例:当询问如何在5090 GPU上使用MLX编写模型时,Instant模式洋洋洒洒写了一整页“这不可能”的理由,而Thinking模式则清晰地解释了具体方法。说“不知道”是诚实,编造一整页理由来否定可行方案则是危险的自信。+“心流状态”与“正确答案”的两难支持快速响应的人提出了一个有趣的论点:等待会打断思维的“心流状态”,短反馈循环对于保持专注至关重要。这确实是真实的用户痛点。但反对者的立场同样清晰:宁可等待一分钟获得经过深思熟虑、参考数十个来源的答案,也不要瞬间得到一个似是而非的回复。毕竟,等待时我们总能找到别的事情做——比如切换到另一个标签页。+ 被忽视的默认设置陷阱一个更深层的问题浮出水面:90%抱怨ChatGPT“愚蠢”的帖子,用户其实都在使用默认的Instant模式。这意味着OpenAI在发布会上展示的基准测试成绩,与大多数用户实际体验到的模型表现之间存在巨大鸿沟。产品设计上的这个选择——用较弱的模型作为默认选项——或许出于成本考量,却在无形中损害了用户对整个产品线的信任。+ 实践建议:场景决定工具讨论中逐渐形成了一些共识:Instant适合的场景:简单定义查询(“EBITDA是什么”)、基础格式转换、不需要验证的日常对话。必须使用Thinking模式的场景:任何需要推理的复杂问题、涉及专业领域的技术问答、需要综合多个信息源的分析。+ 知识截止日期的局限性有用户指出,对于涉及2025年新技术的问题(如刚发布的显卡配合活跃开发中的框架),期望一个训练数据主要来自2025年之前的模型给出准确答案本身就不现实。解决方案是开启网页搜索功能,或者为模型提供更多上下文。这提醒我们:理解工具的边界,比抱怨工具的不足更有建设性。+ 一个值得深思的产品哲学问题这场讨论最终指向一个核心矛盾:AI产品应该优先满足用户对“即时满足”的需求,还是坚守“宁慢勿错”的准确性底线?当前的解决方案似乎是把选择权交给用户——但前提是用户得知道自己有选择,并理解不同选择的代价。reddit.com/r/OpenAI/comments/1q4e4zn/dont_use_gpt52_autoinstant_in_chatgpt