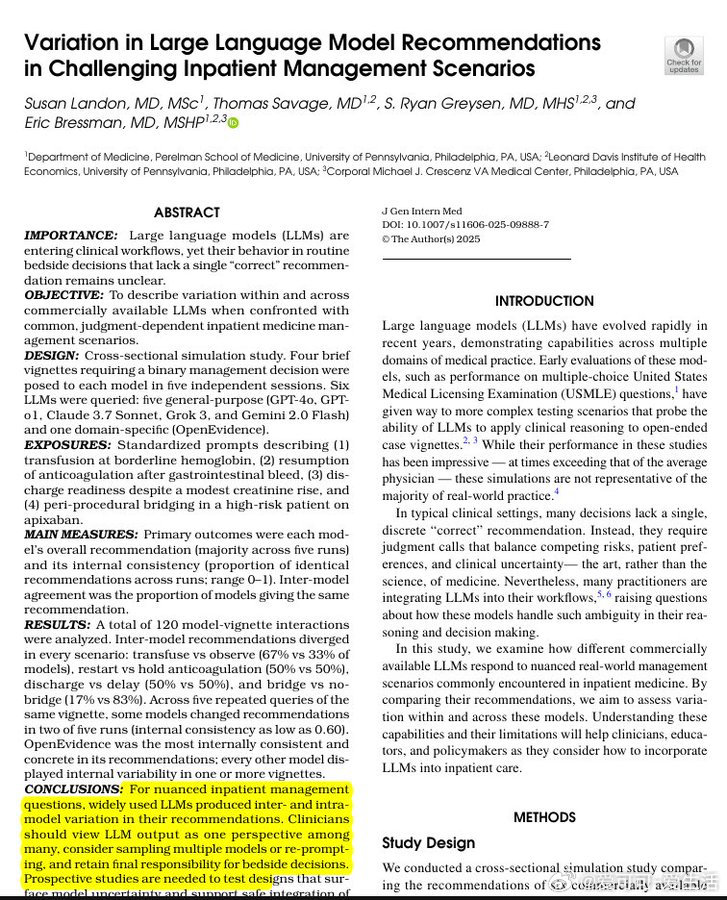

医疗AI又曝新难题:大型语言模型(LLMs=)在医院临床决策中表现出严重不稳定性。

一项最新研究对6款医疗相关模型进行了测试,针对4个常见住院病例反复提问,结果显示:

- 不同模型对同一问题给出截然不同的建议,比如50%建议立即重新用血液稀释剂,50%建议延迟观察。

- 同一模型多次回答一致性仅约60%,意味着回答反复翻转。

- 绝大多数模型未主动追问缺失信息,导致微小措辞差异引发方案分歧。

- 不同模型侧重风险不同,有的关注出血风险,有的担忧肾损伤或早期出院后的后果。

- 没有任何两款模型能在所有案例中保持答案一致。

研究指出,这些LLM更适合辅助“框架选项”,而非做出最终判断。临床医生应多模型对比、反复提问,且始终承担最终决策责任。

评论中专家普遍认为:

- 这反映了当前模型训练和架构的局限,尤其是通用型LLM缺乏专门医疗数据训练。

- 医学决策本身就带有不确定性,医生在复杂病例中也会反复权衡和调整方案。

- 提升AI稳定性必须依赖更精准的训练、外部数据支持(如检索增强生成)和可审计的推理过程。

- 研究诊断了变异性,但如何管理和利用这种变异性,是未来真正的挑战。

- 目前阶段,AI绝非临床决策的替代品,而是辅助工具。

总结来看,医疗AI正处于“探索期”——它能够提出可参考的诊疗思路,但远未达到可完全信赖的成熟度。未来需要更多专门训练、更严谨验证和人机协同设计,才能真正提升临床安全与效果。

原文链接:x.com/rohanpaul_ai/status/1985165030594330788

这项研究提醒我们,医疗AI不是魔法,理性看待其局限,科学推进技术,是帮助医生和患者的正确路径。