今天在嘉定图书馆待了一下午,啃了个100页的报告,没有痛苦,全是享受。这篇对于本土生成式AI的思考比较到位,没有太多假大空,总结几个重点:

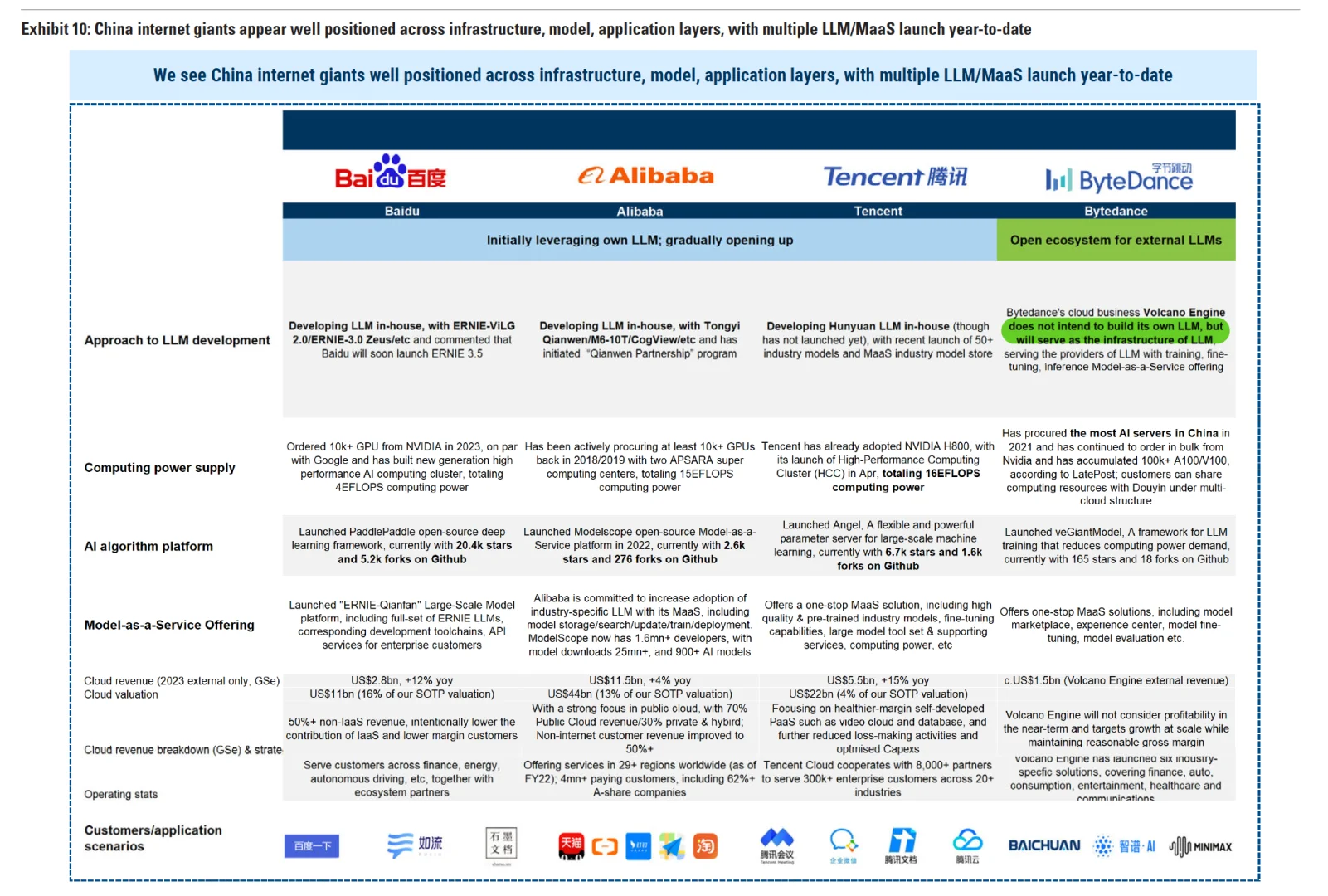

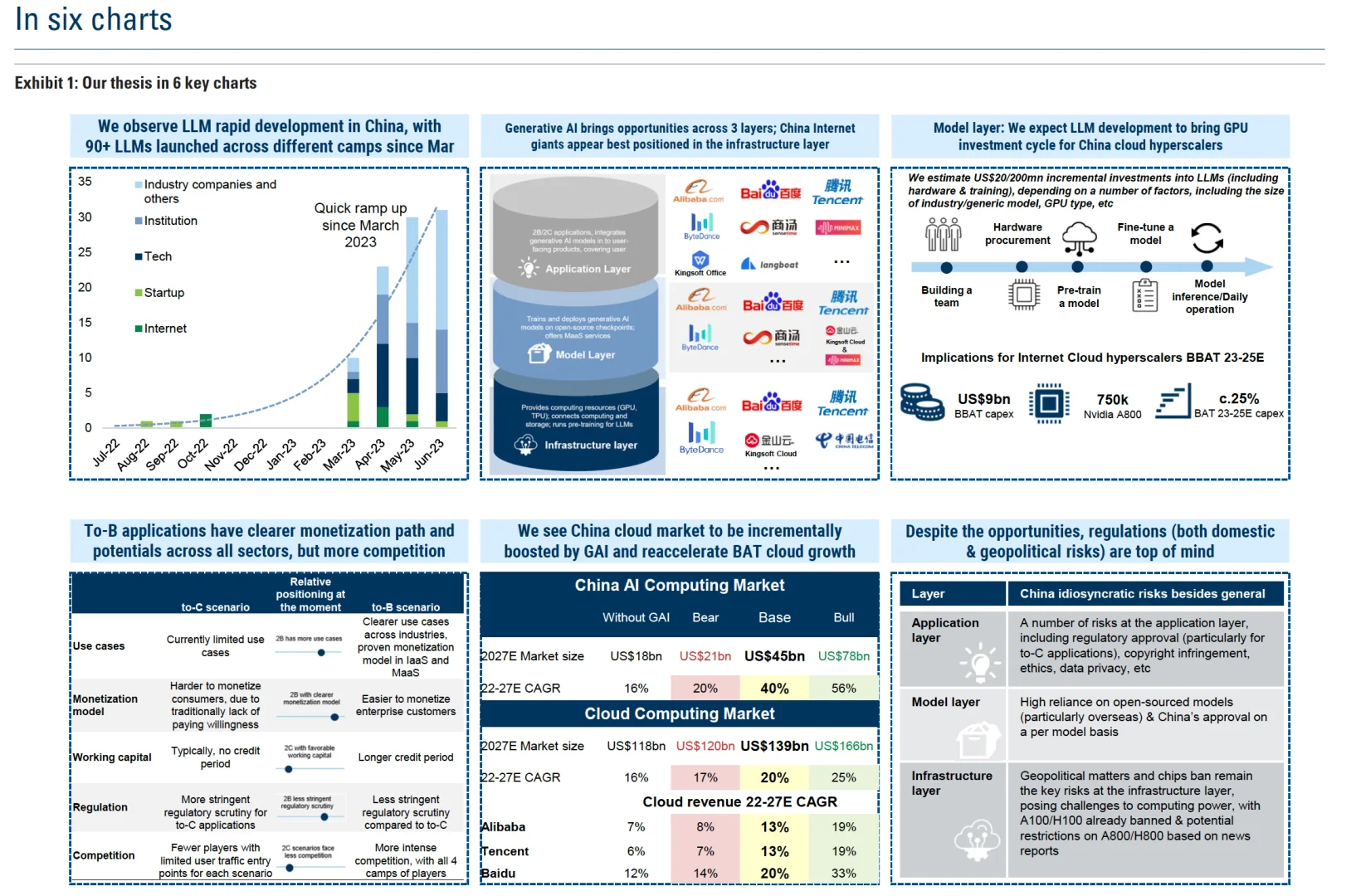

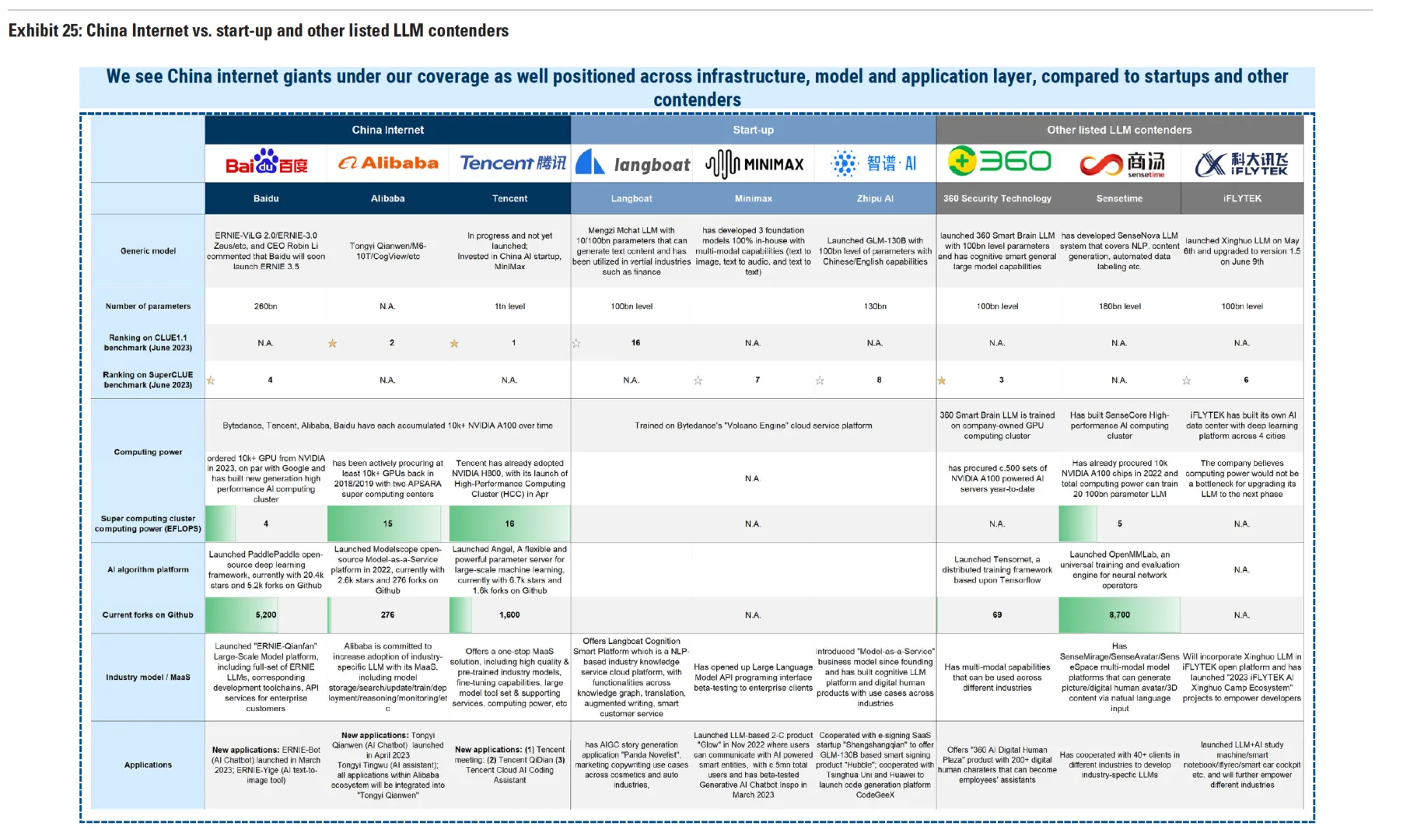

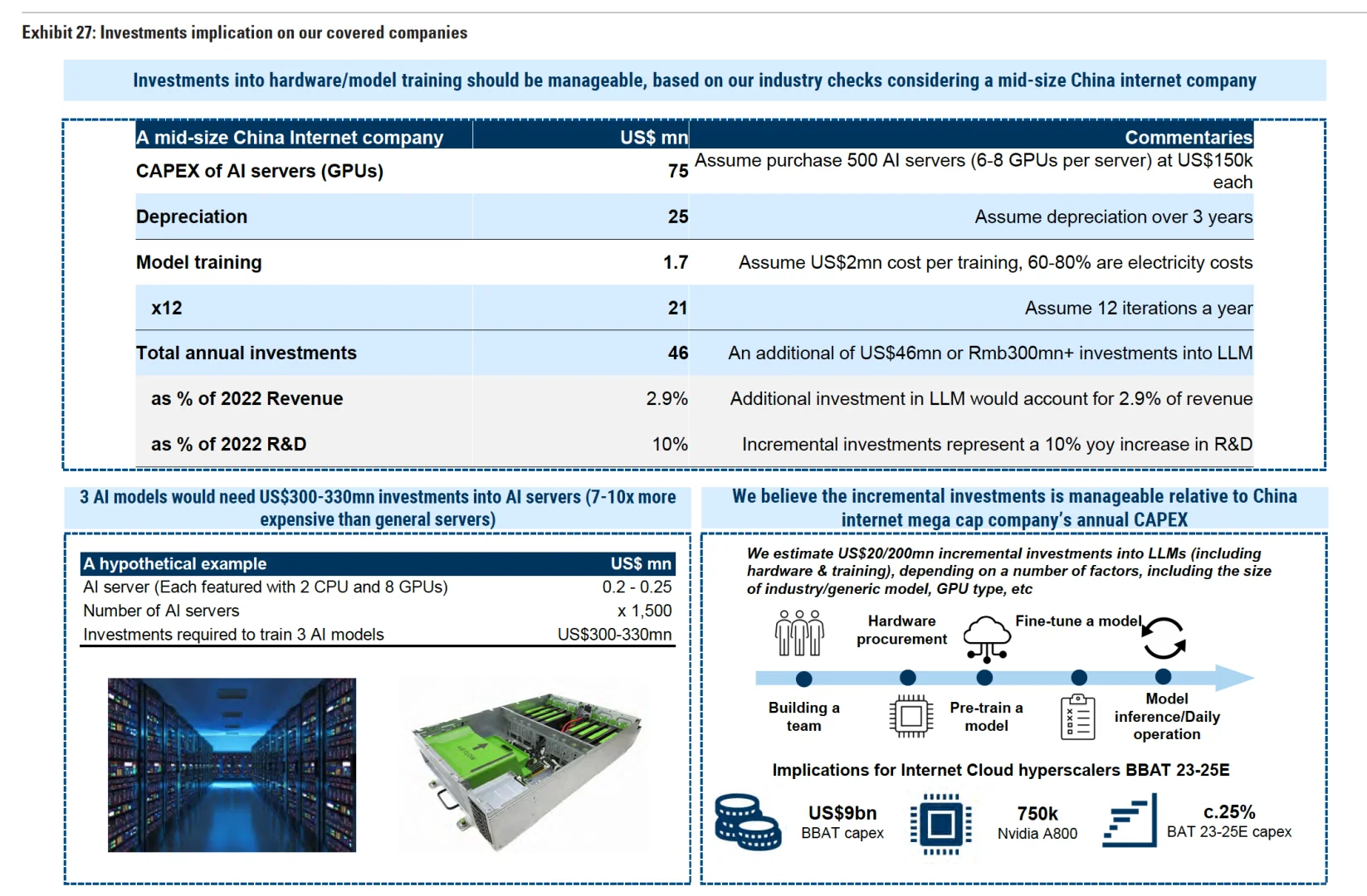

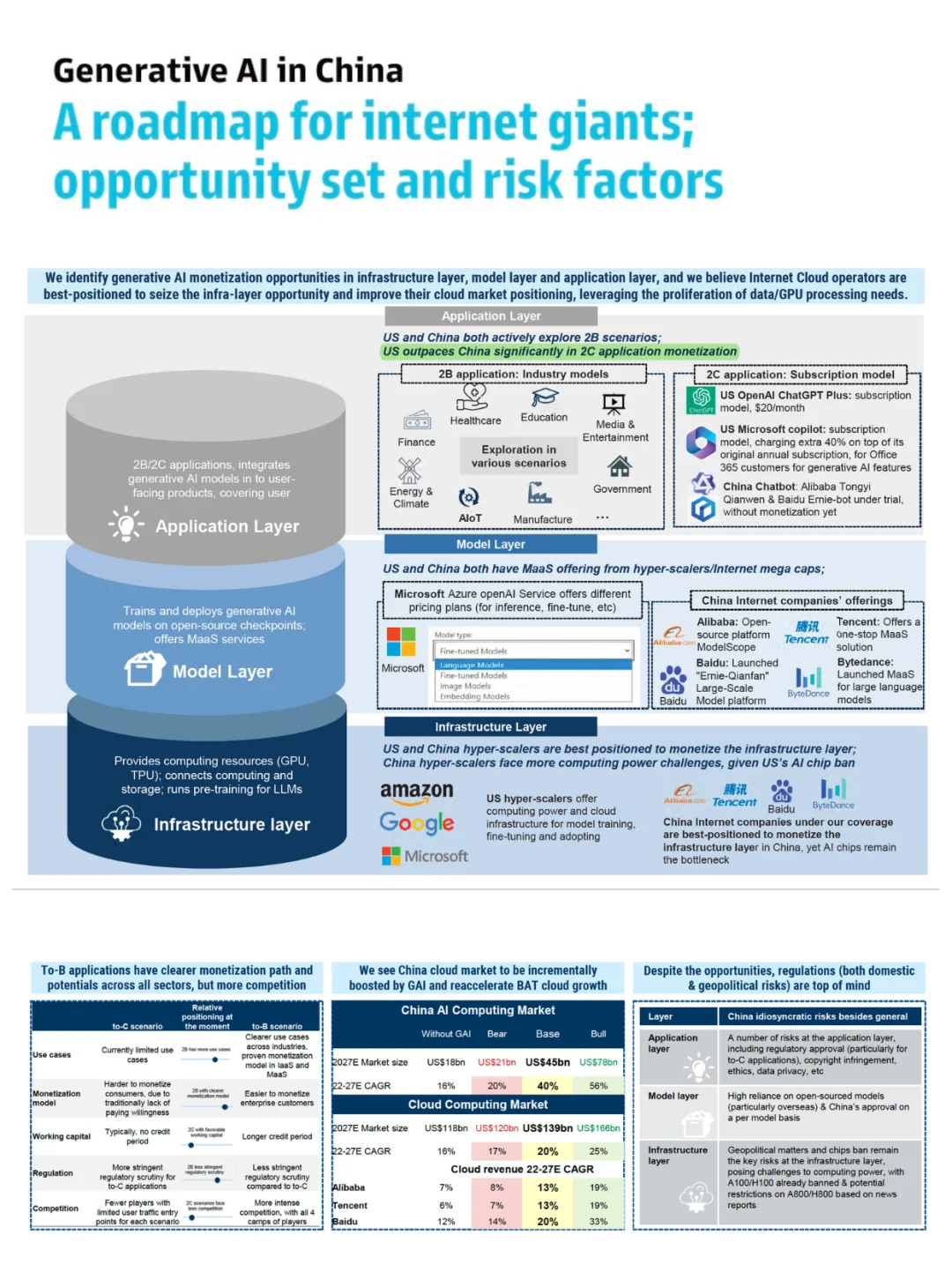

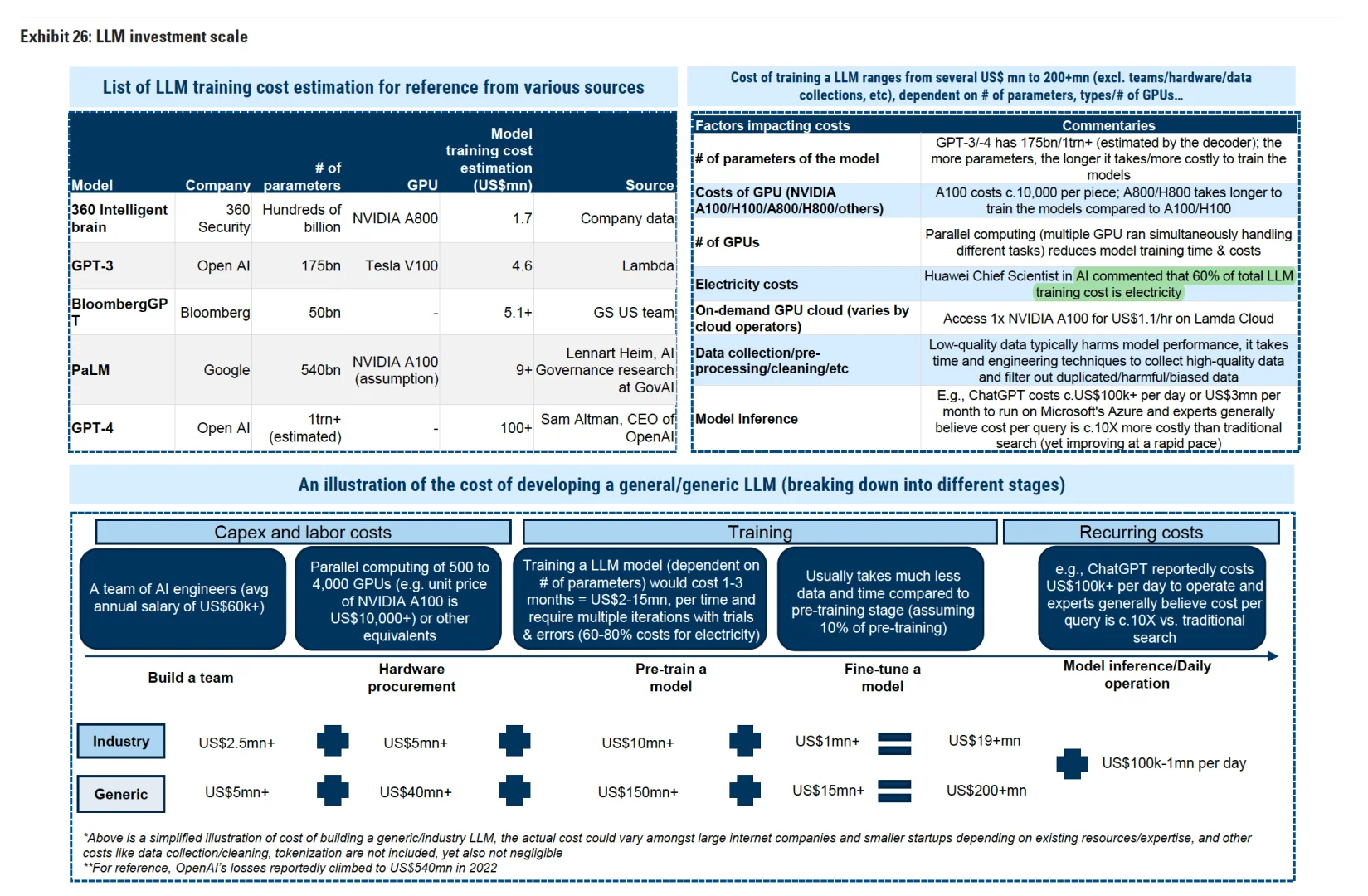

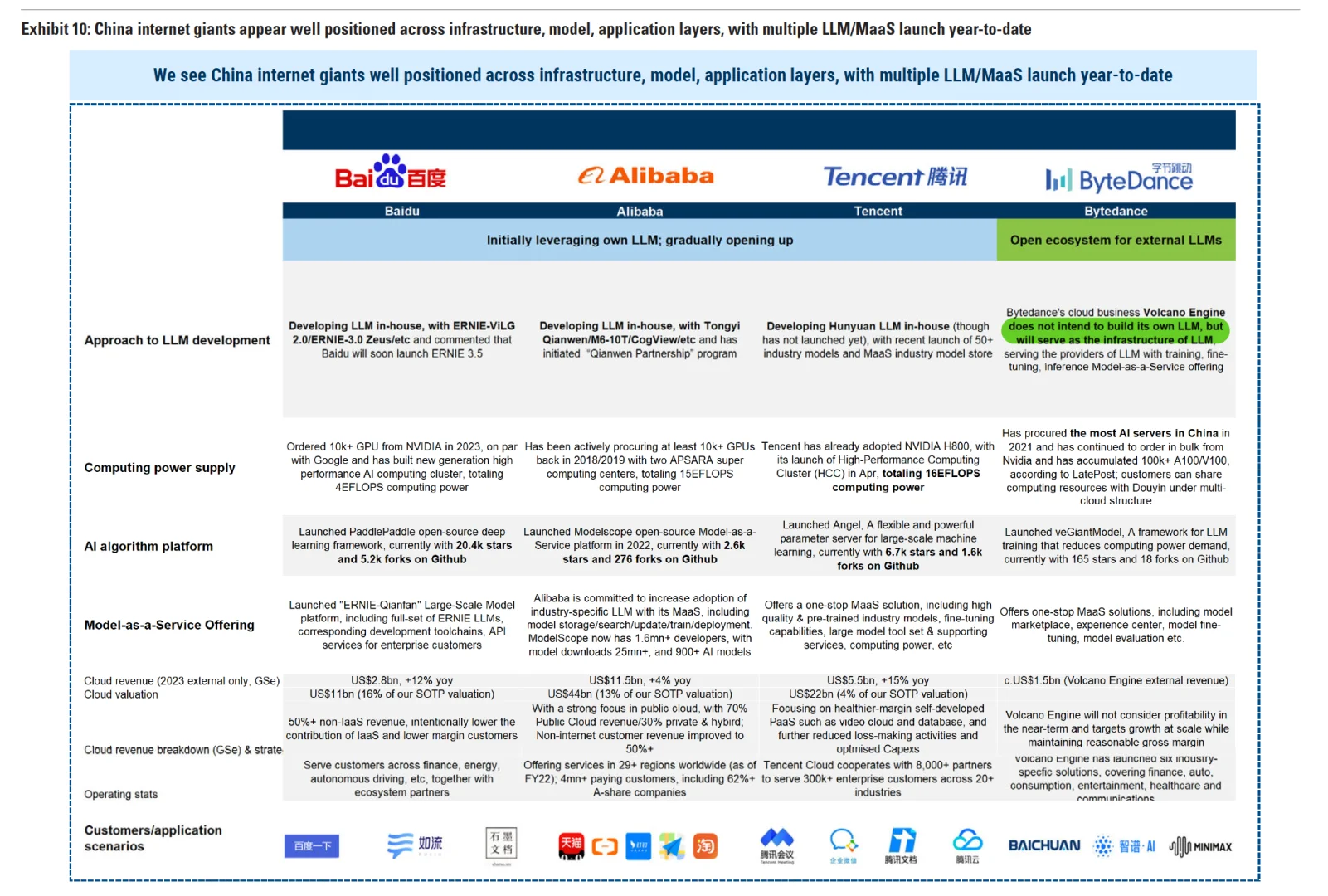

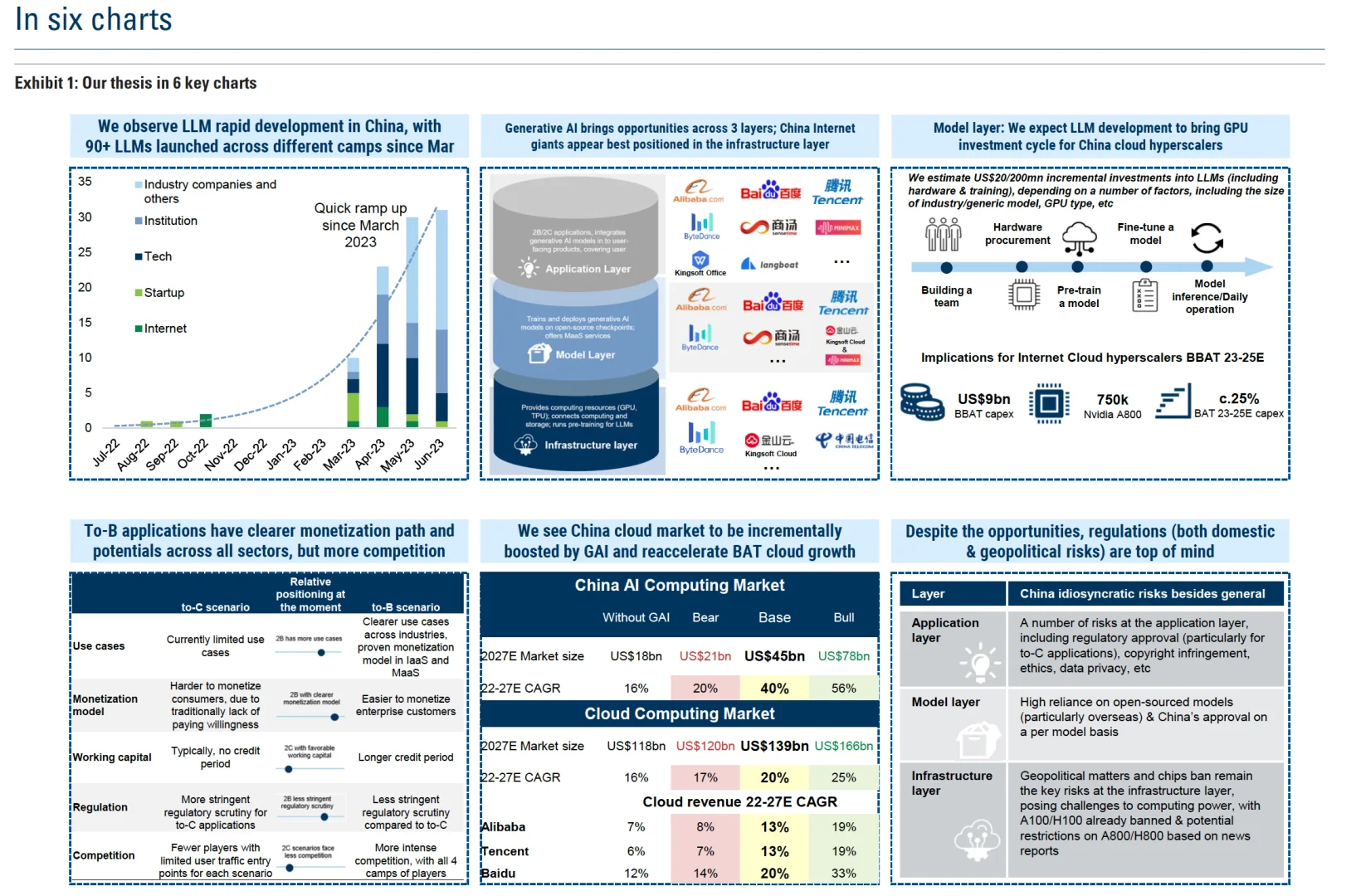

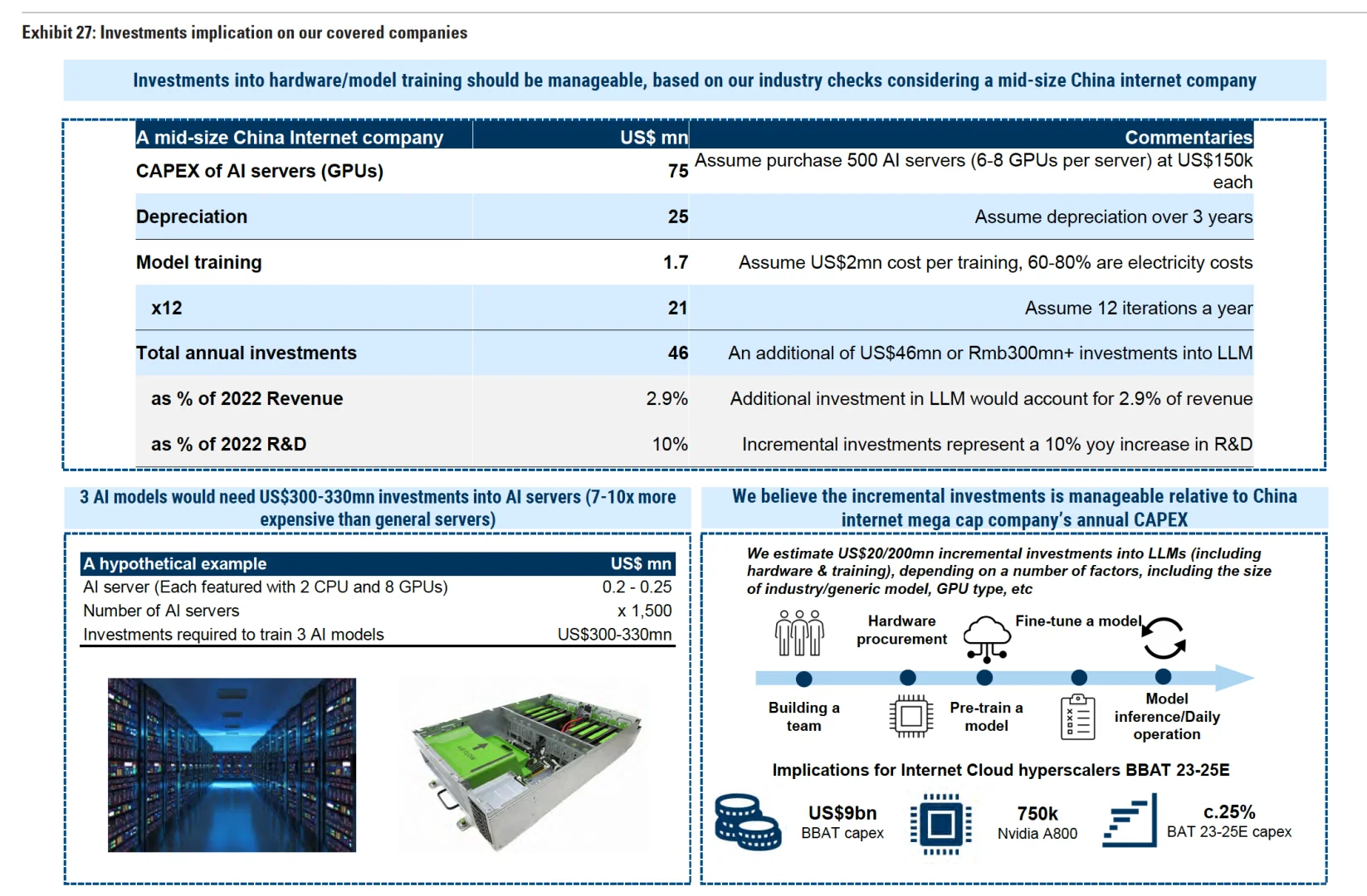

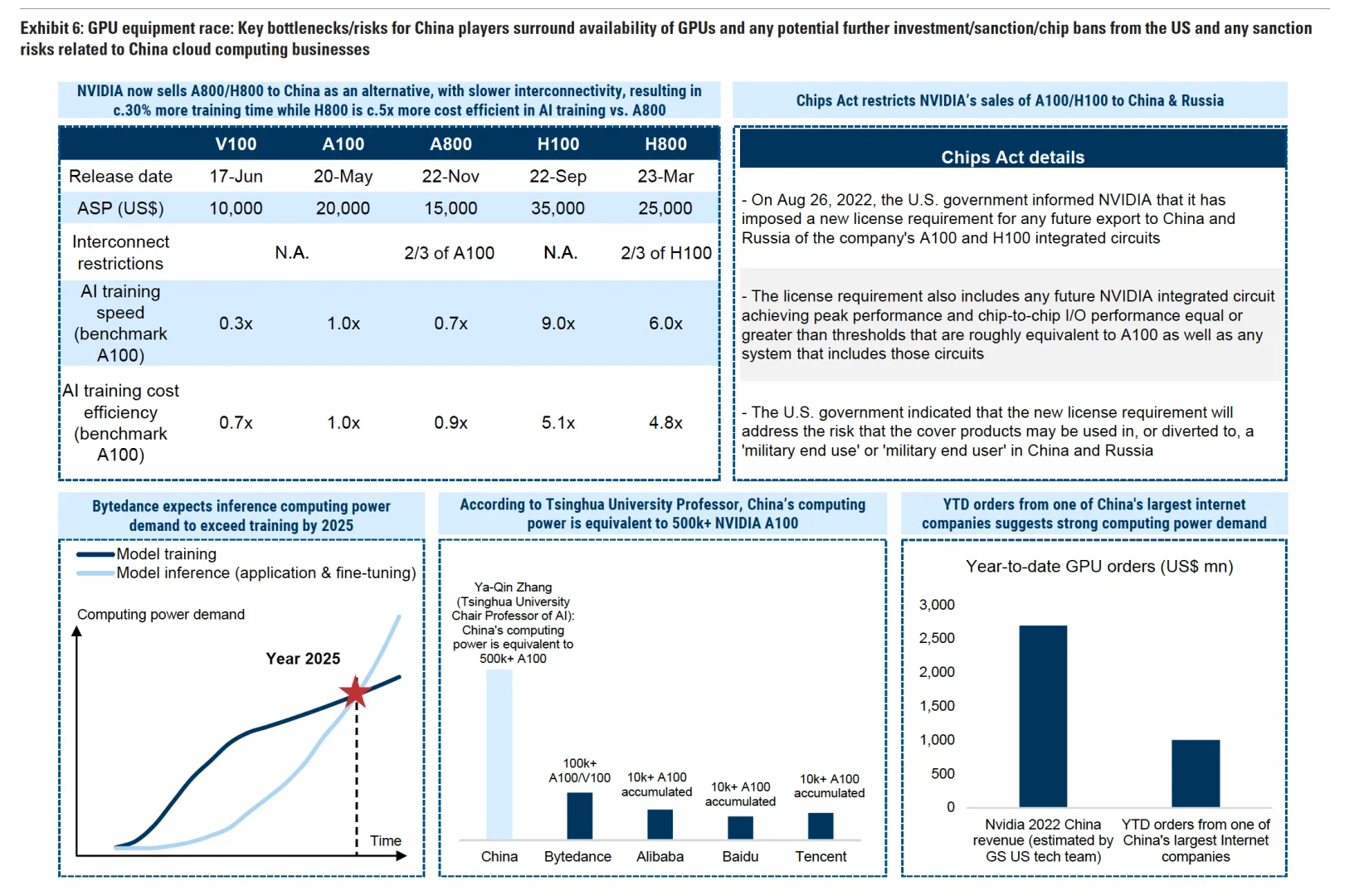

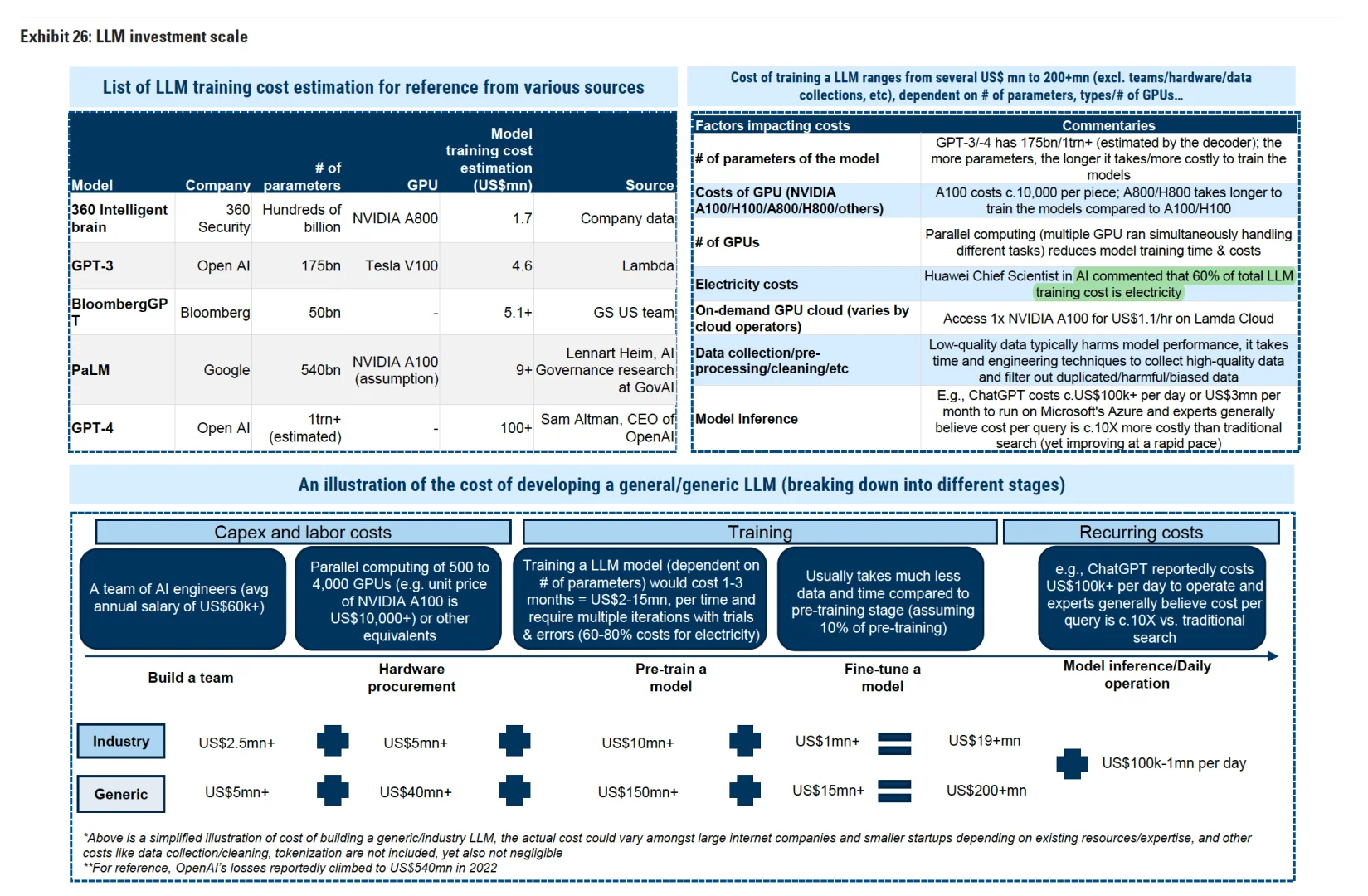

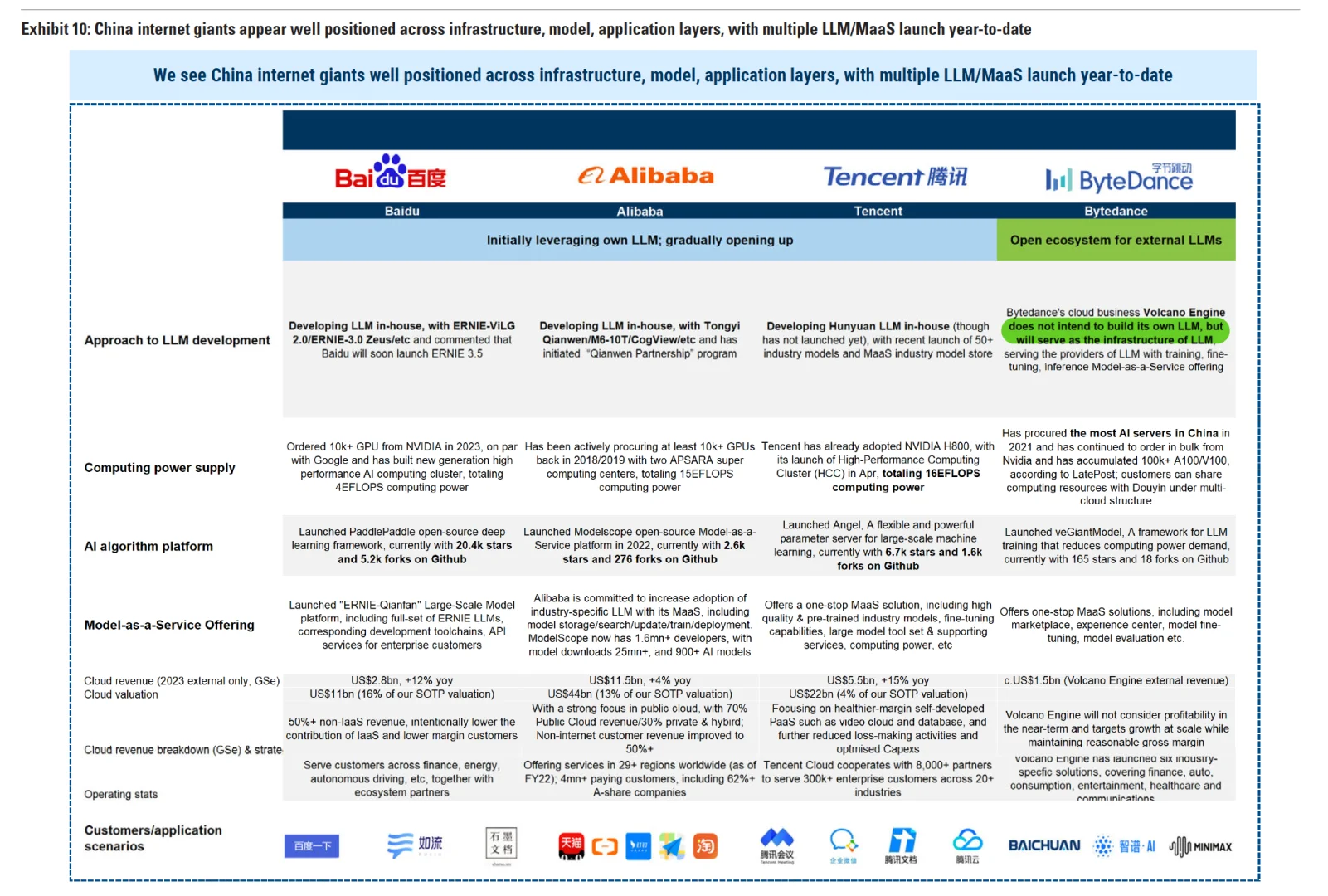

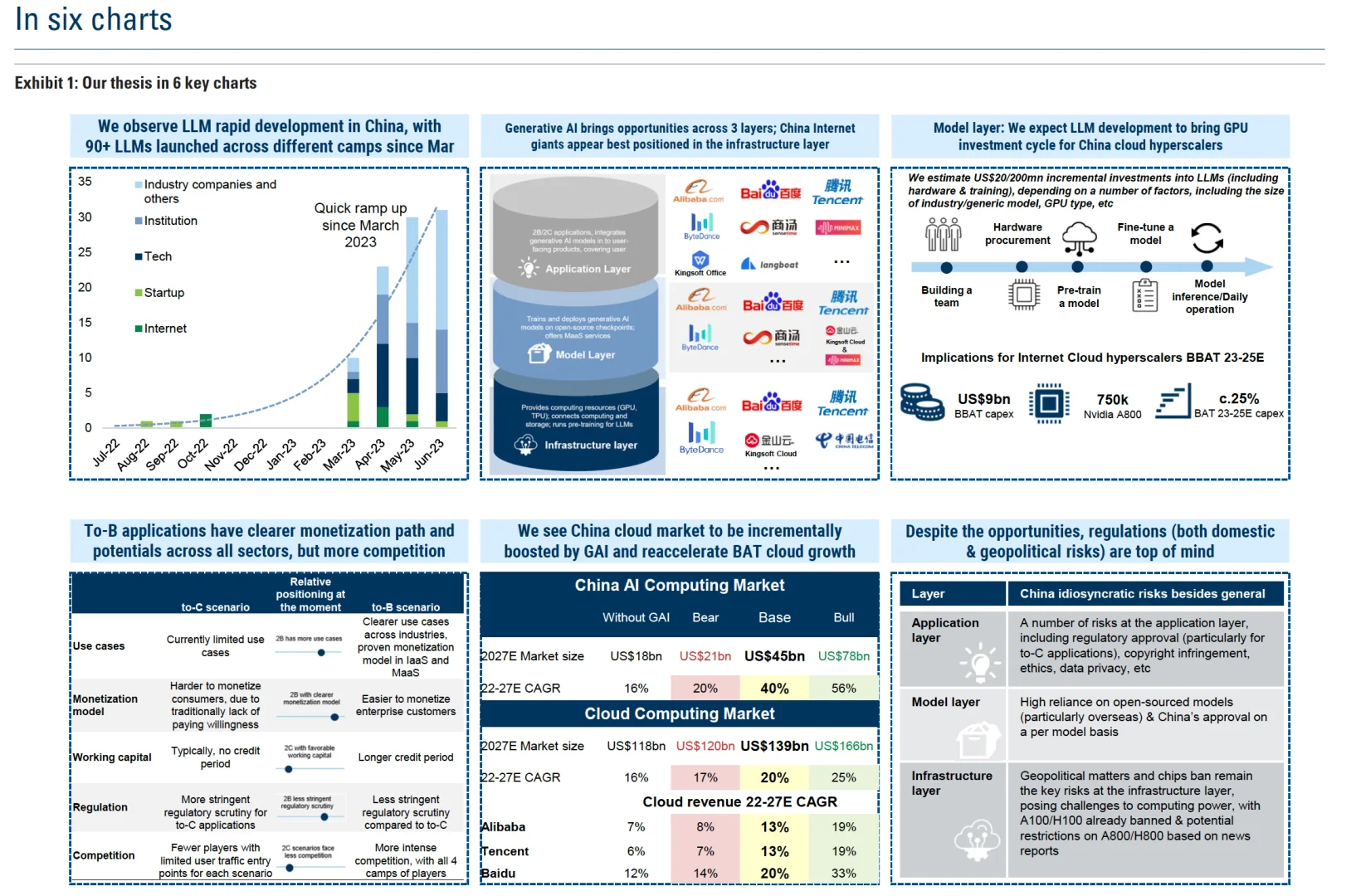

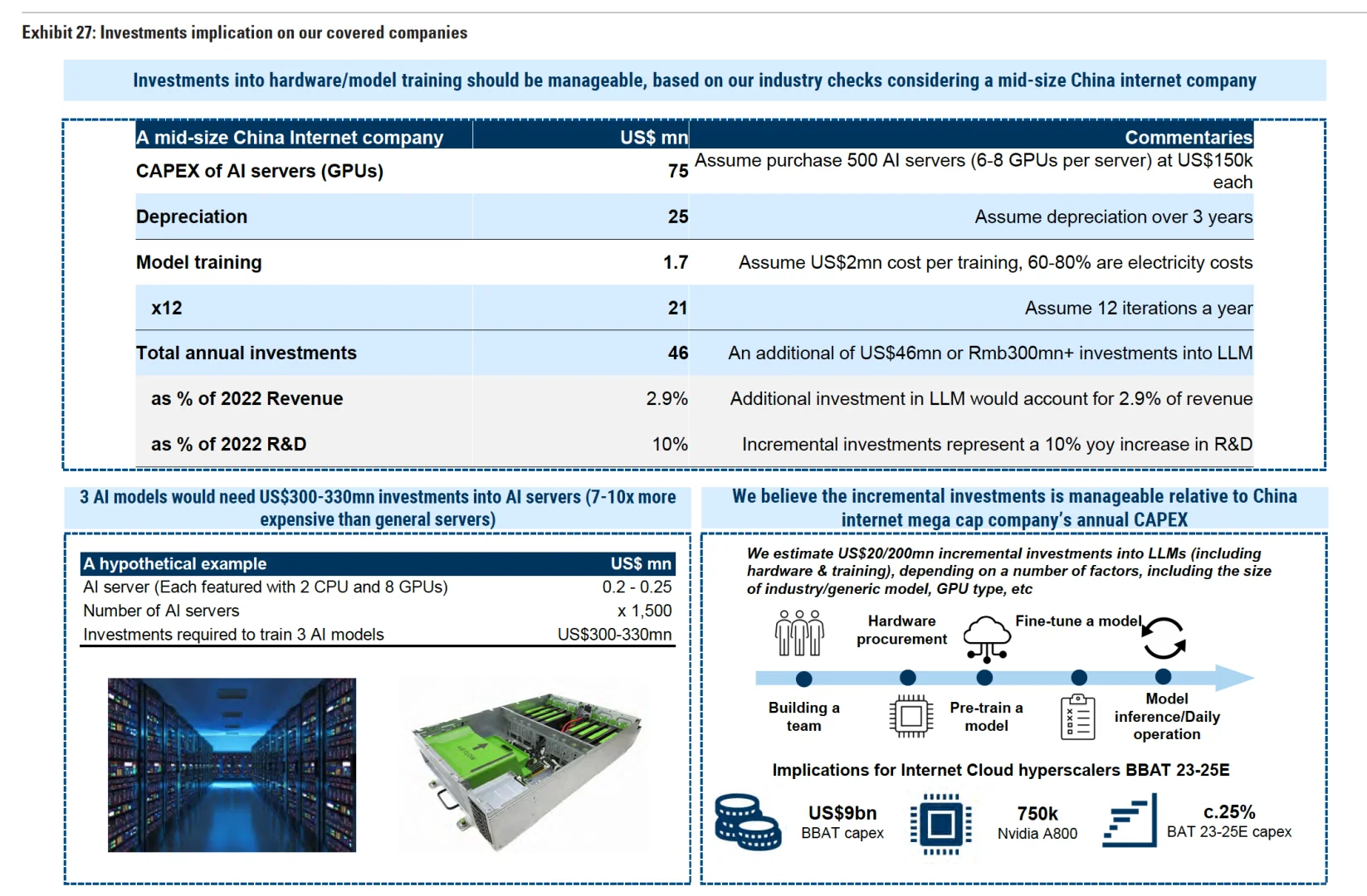

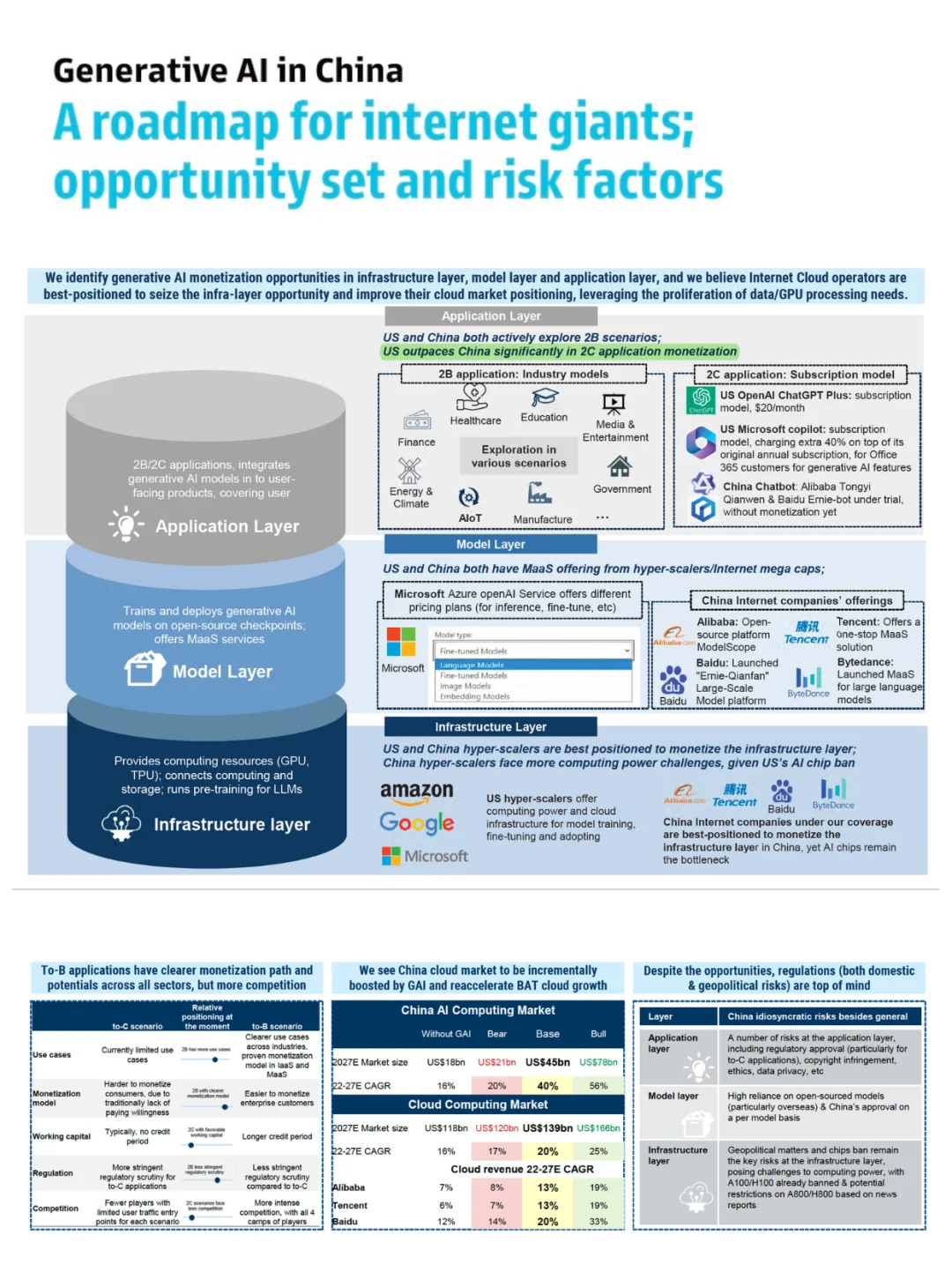

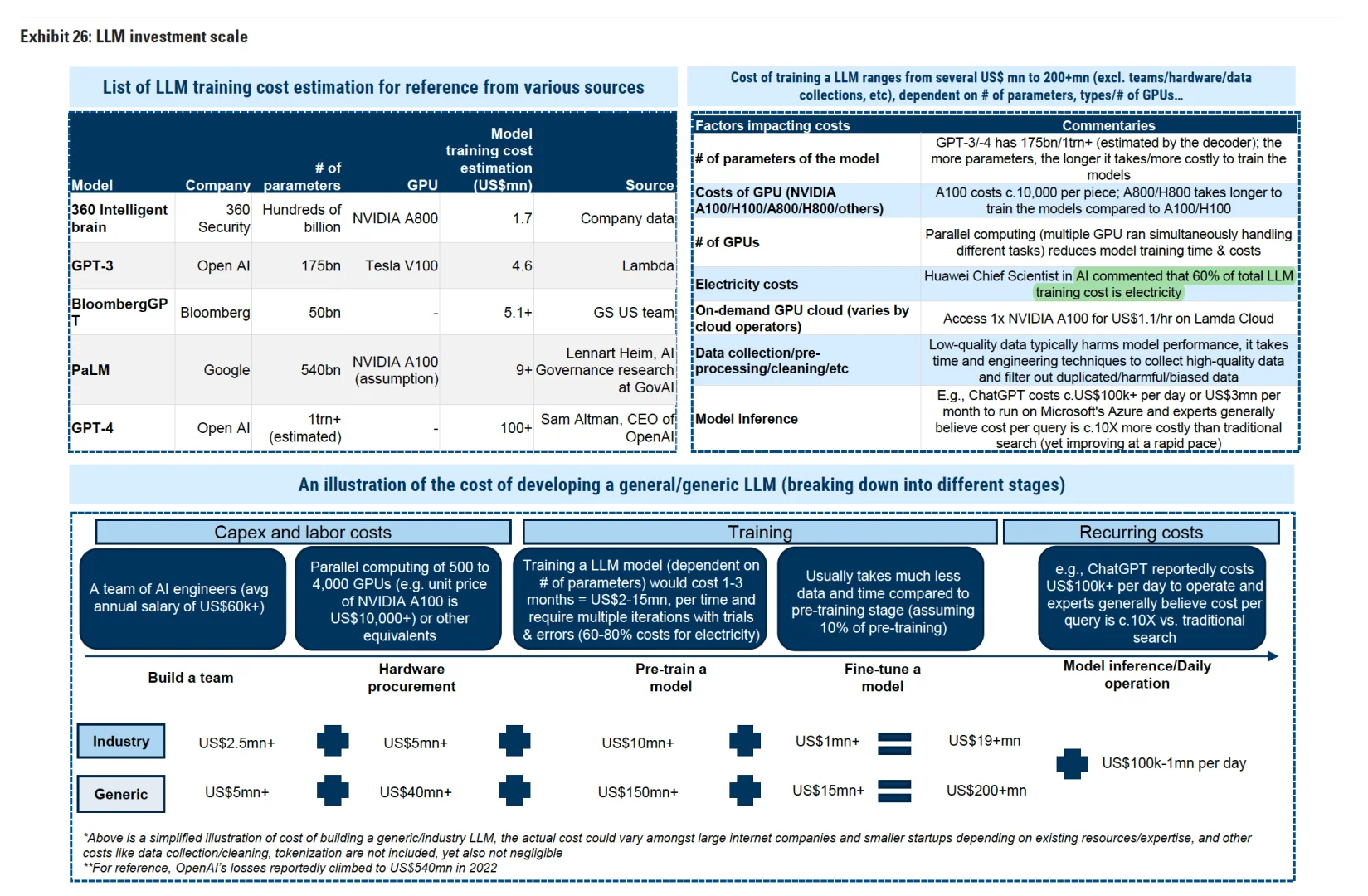

▪️市场规模:2023-2025 年期间,BBAT 将为生成式AI投入 90 亿美元的GPU资本支出(75 万个A800 的 GPU),占该期间BBAT总资本支出的 25%

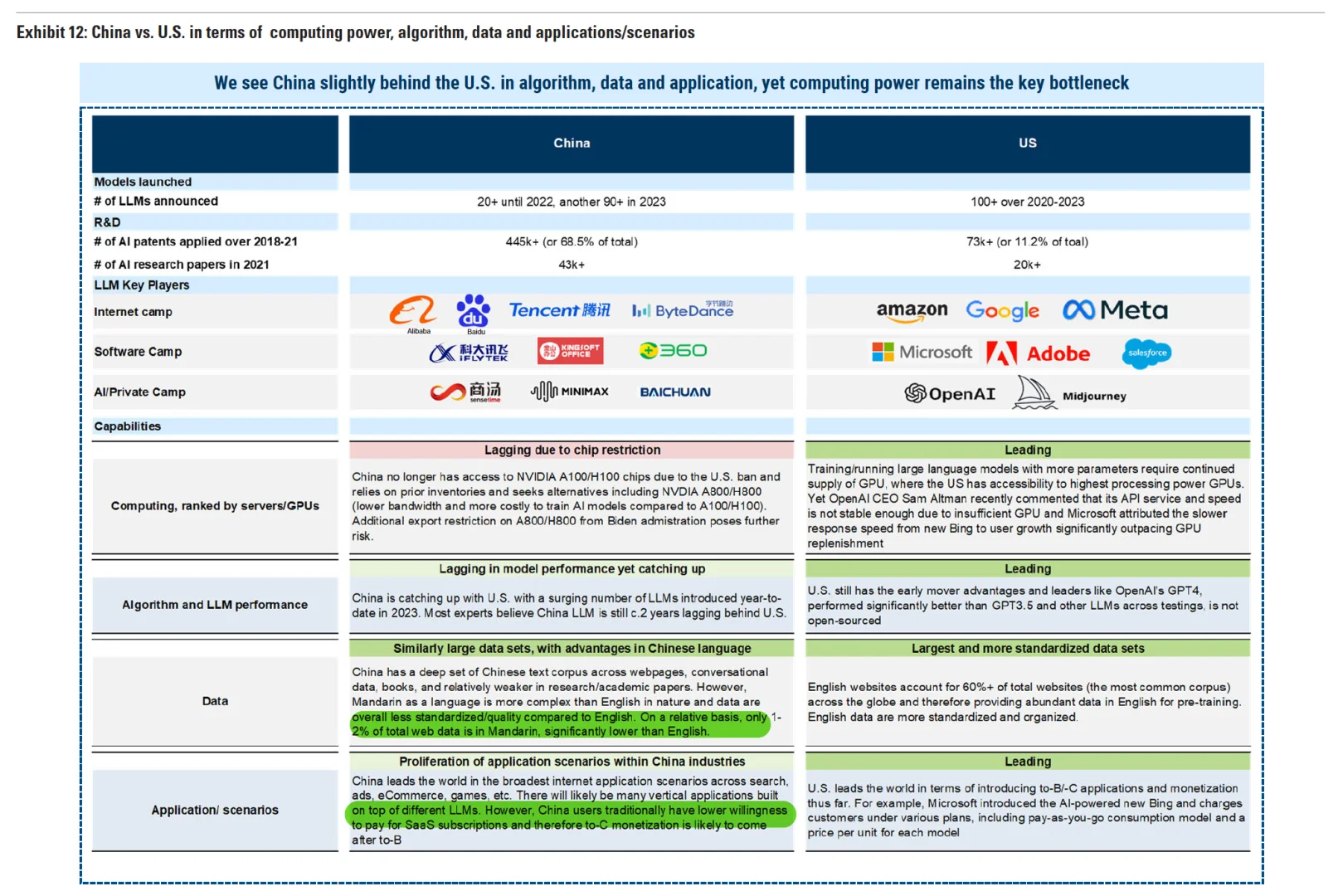

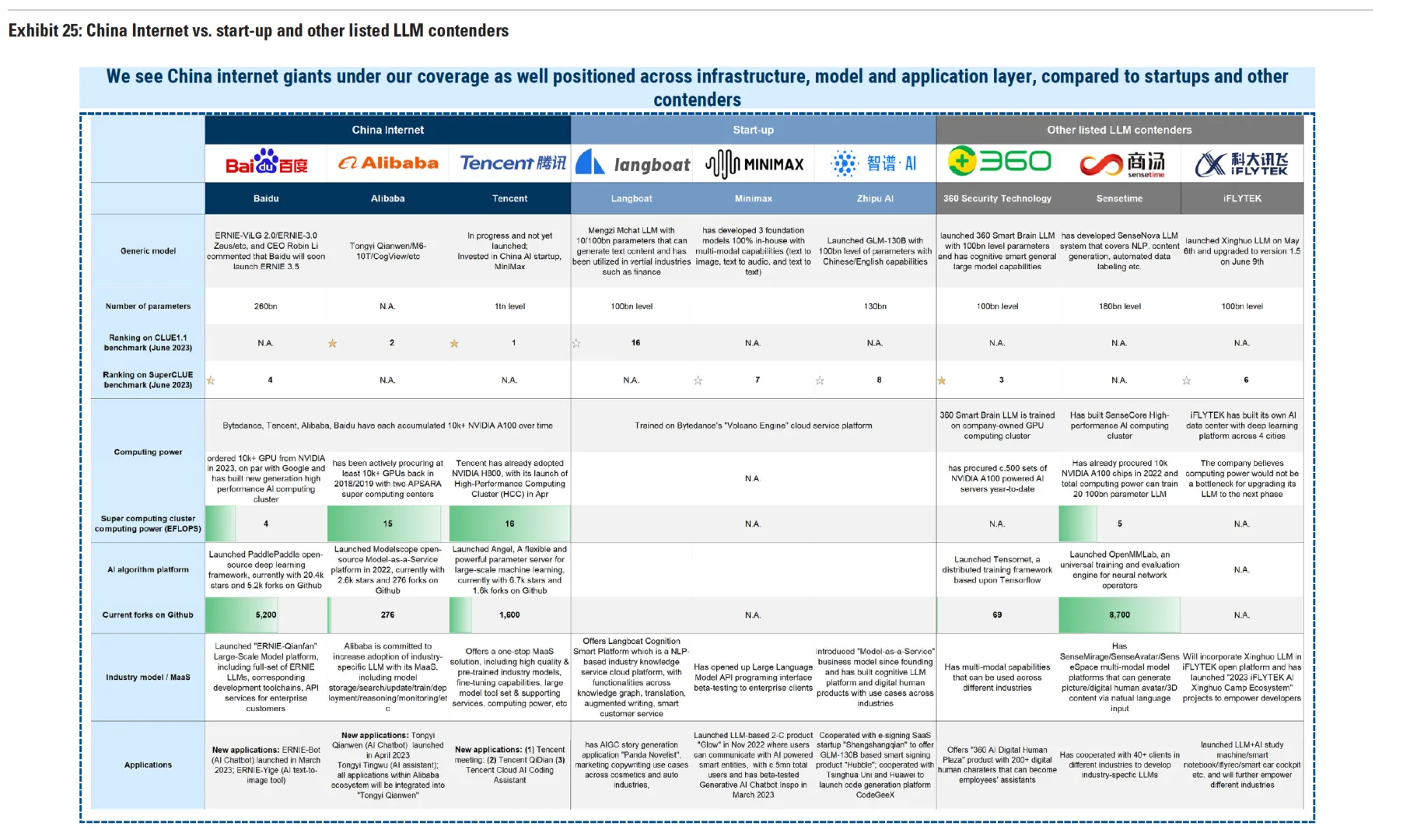

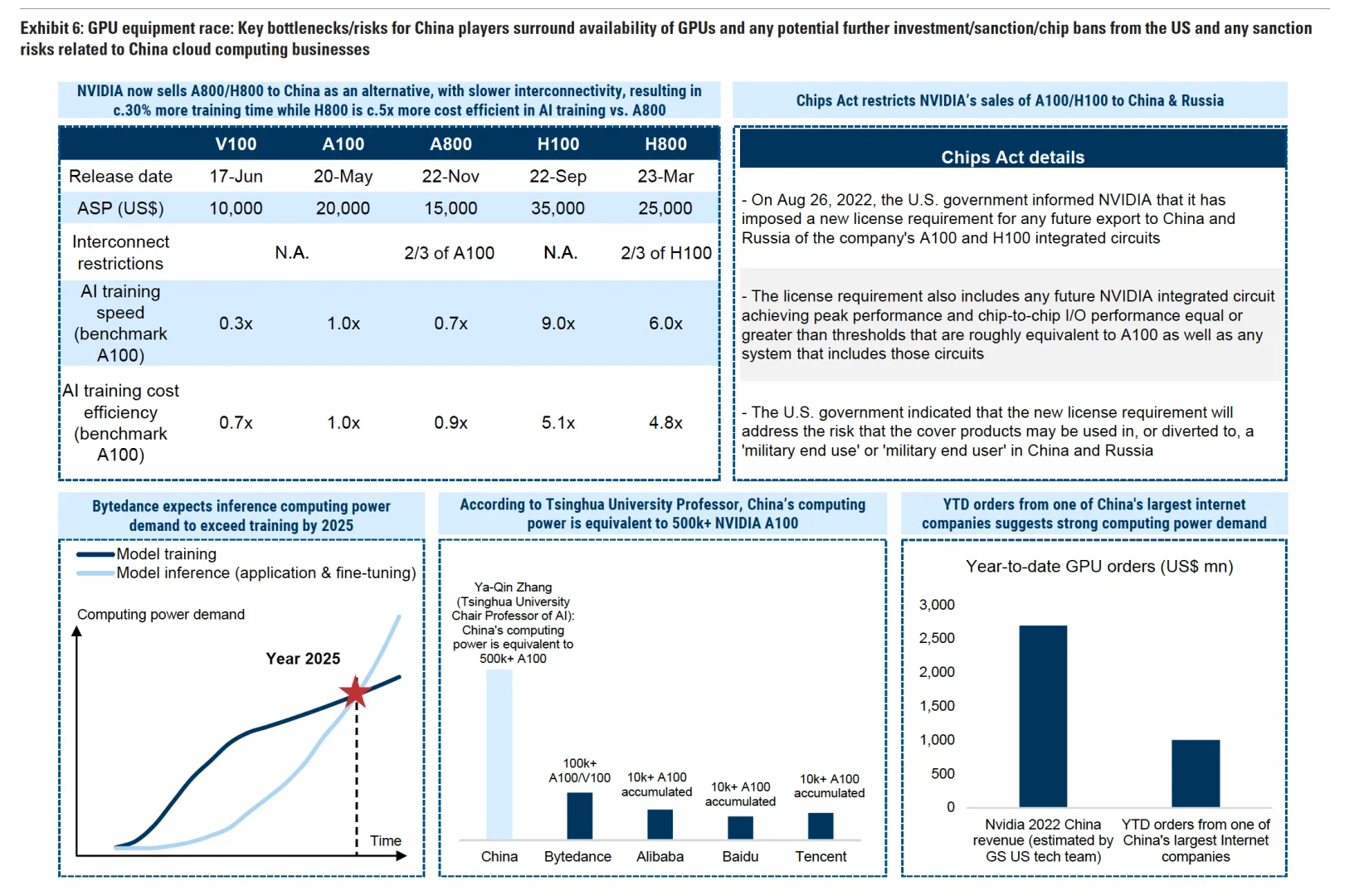

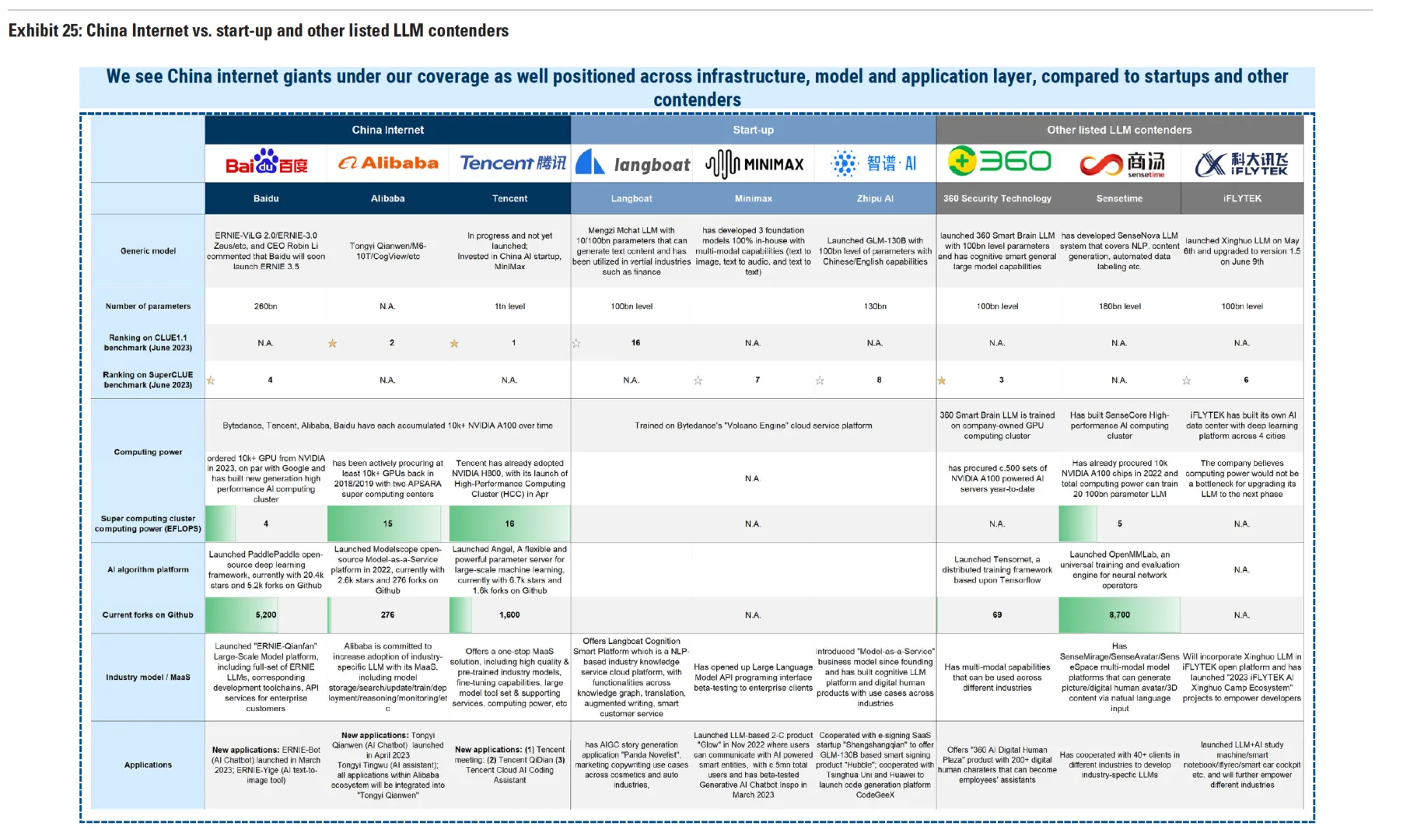

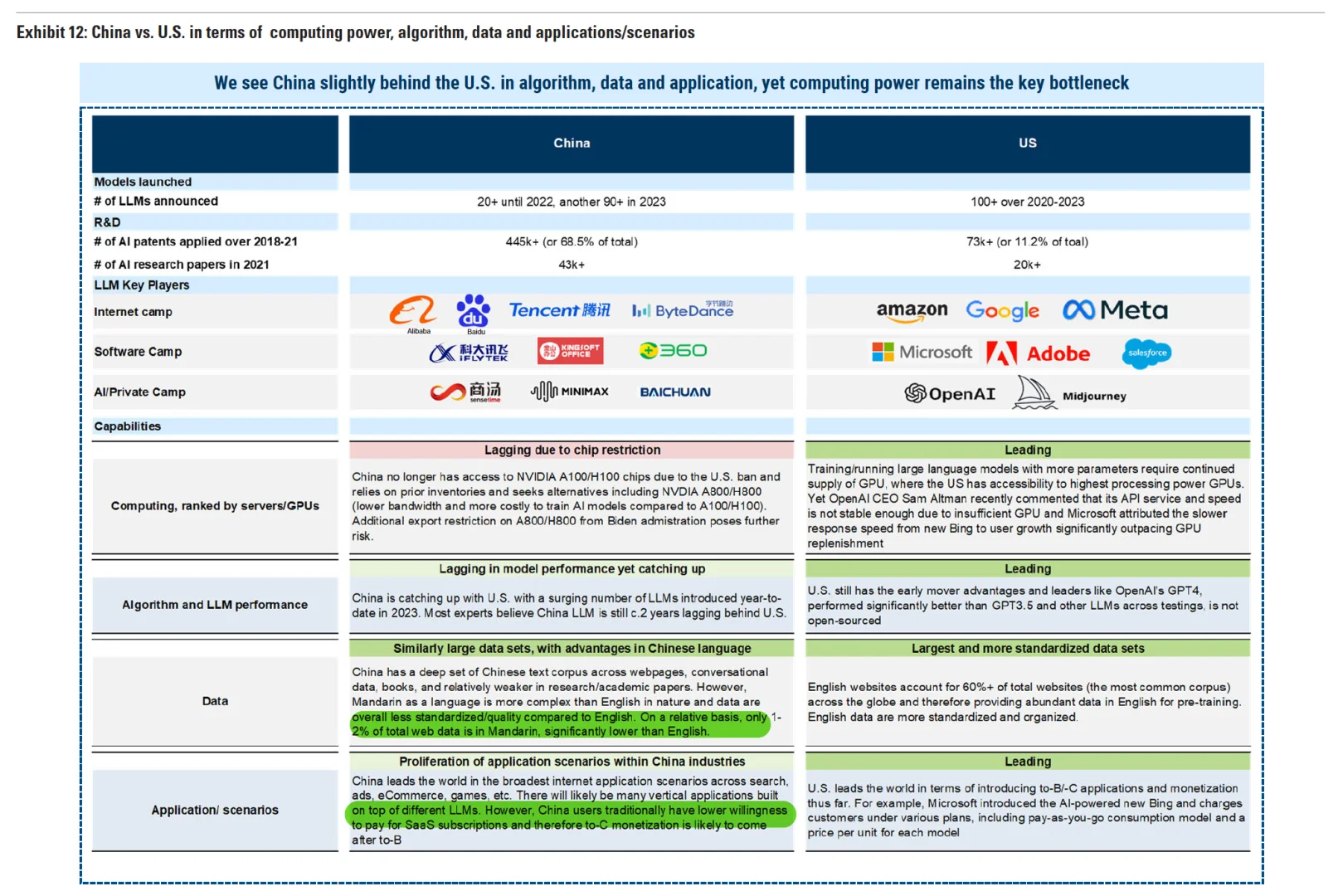

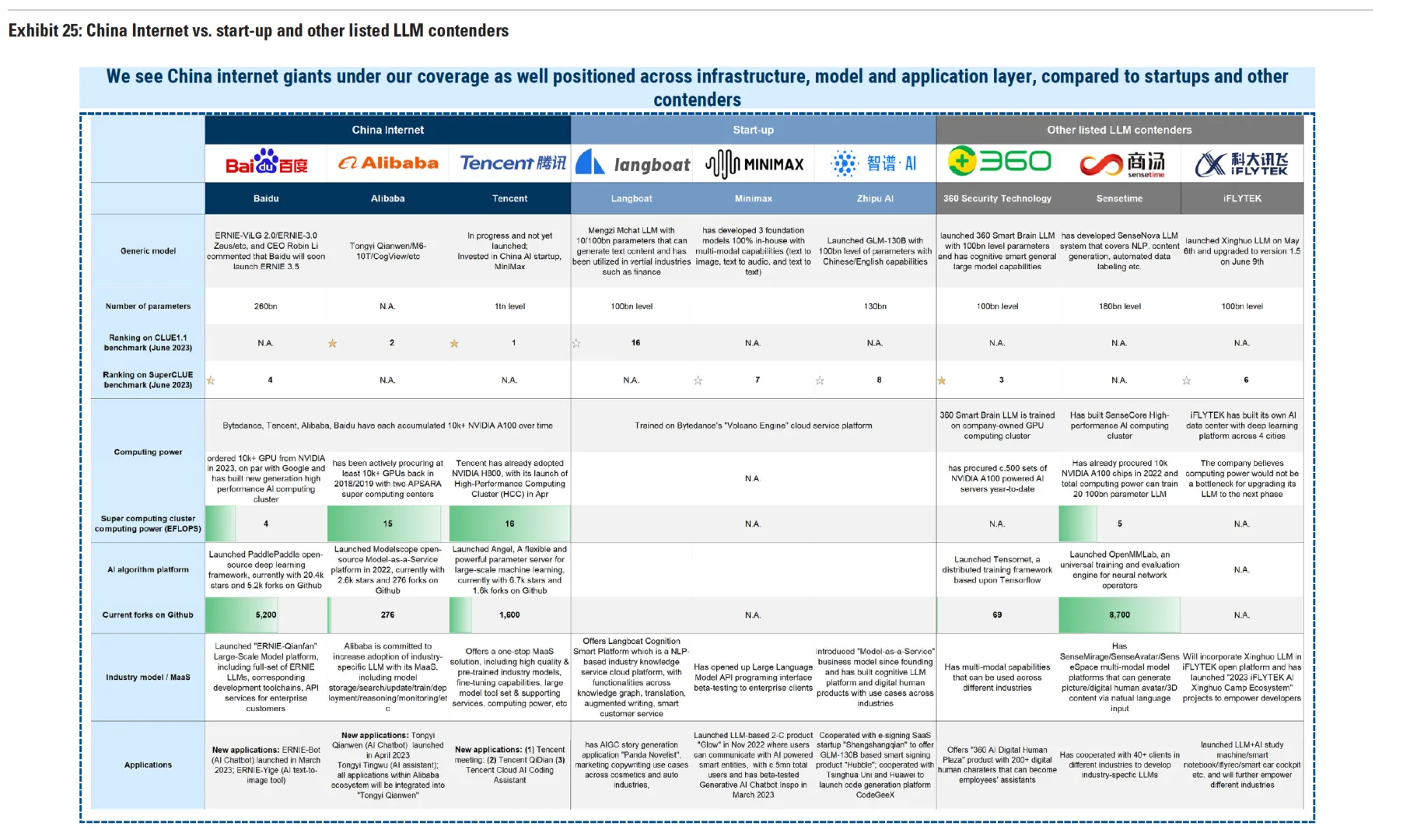

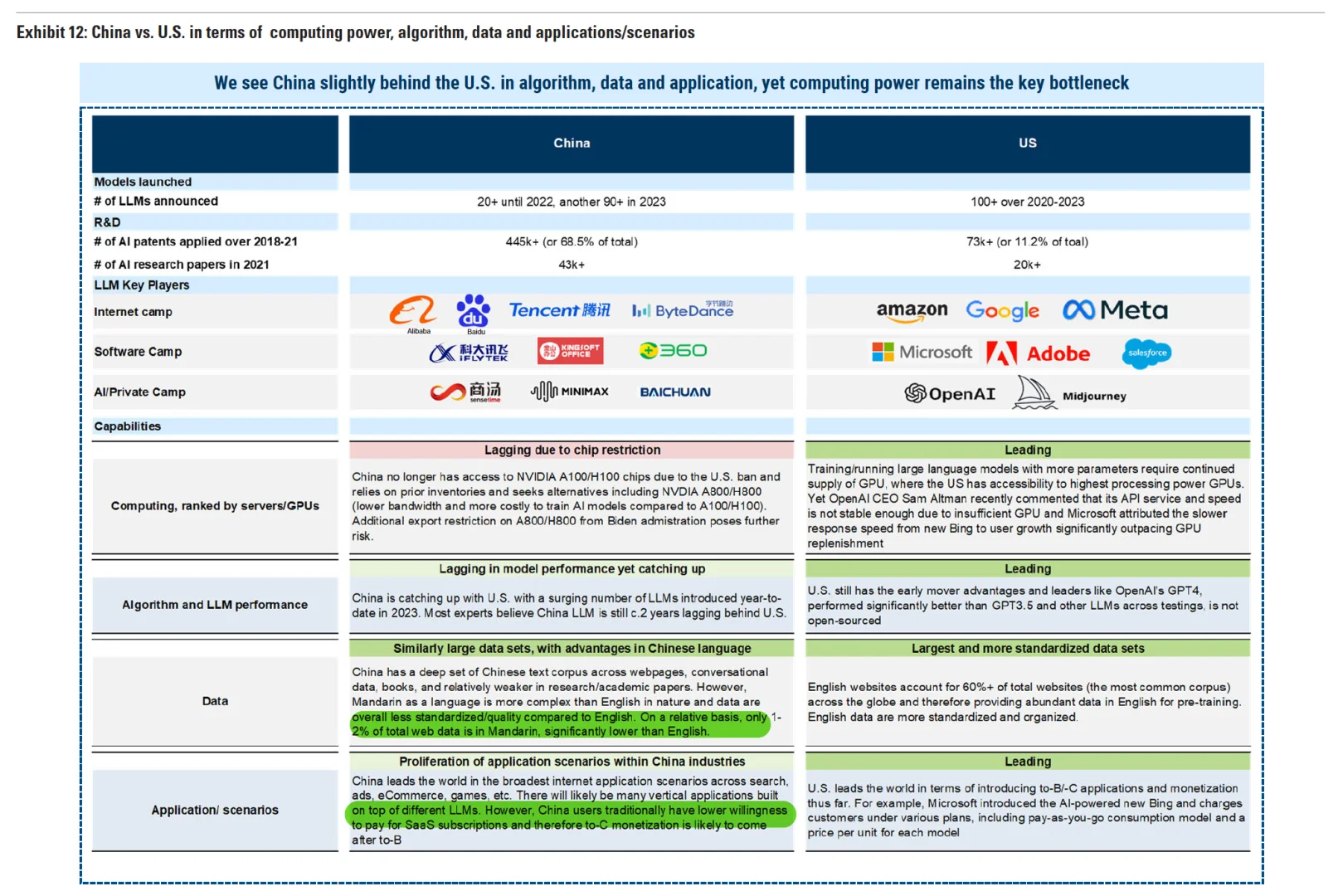

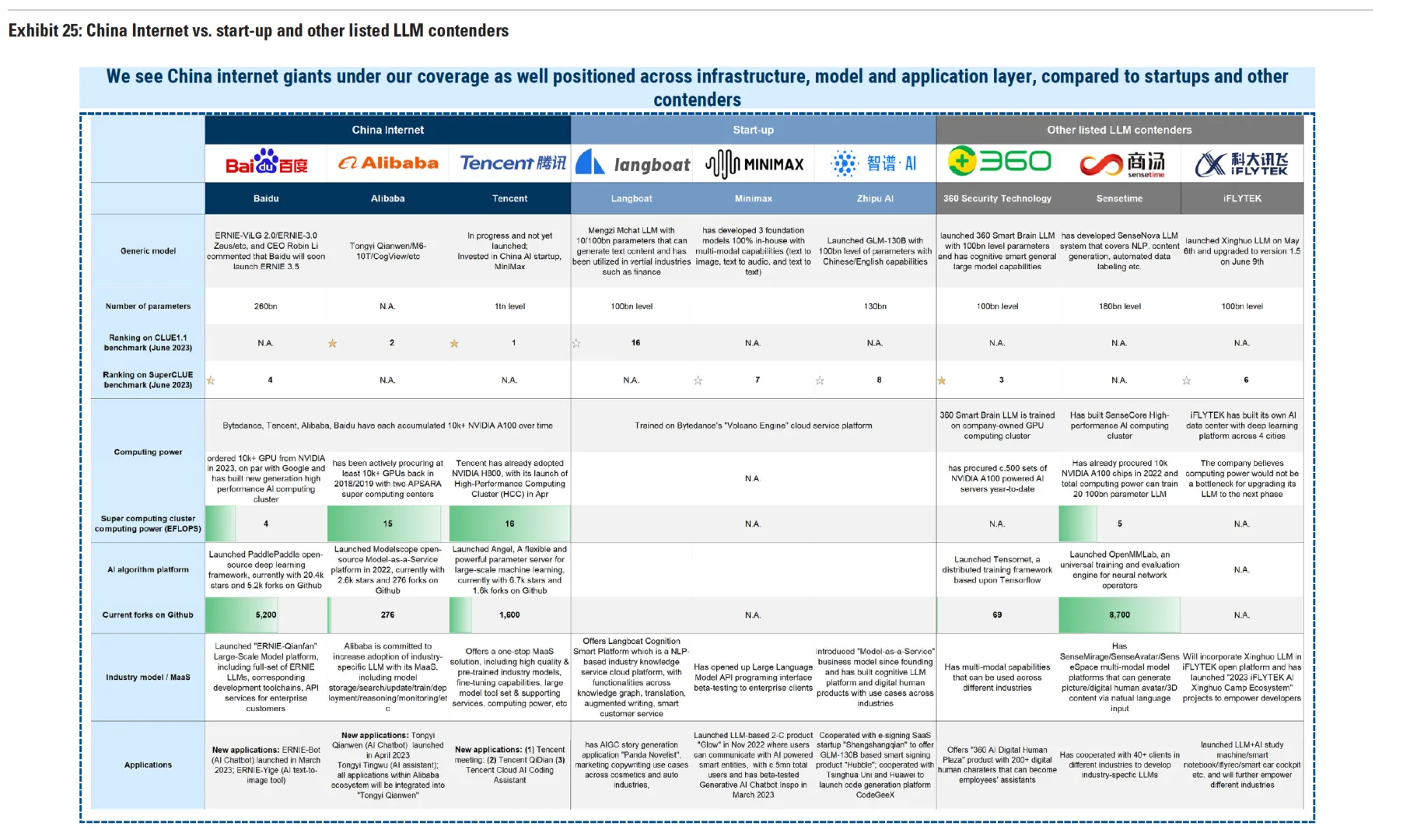

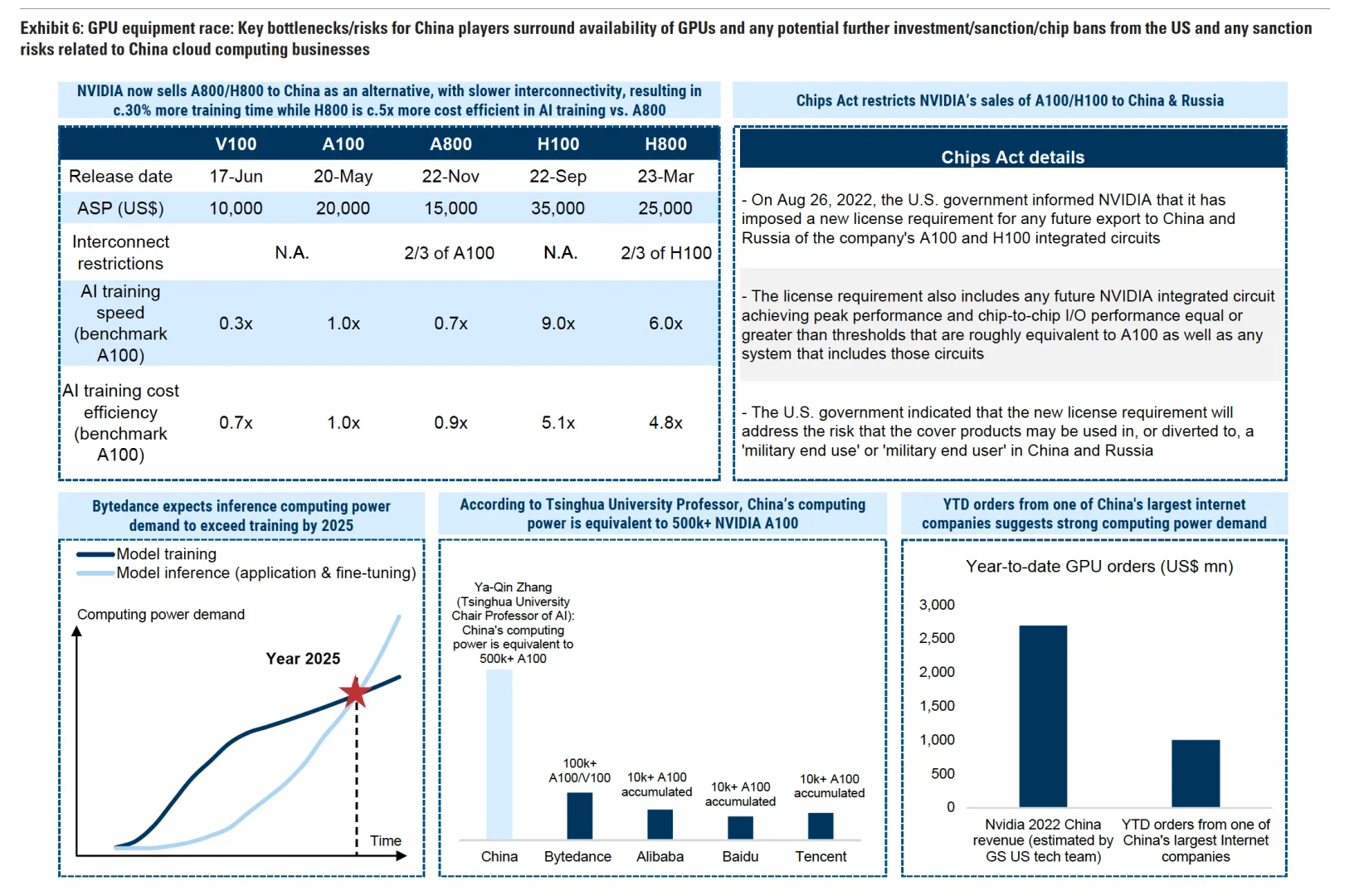

▪️行业层面:GPU地缘zz风险很高。市场对本土公司使用国外云平台训练AI模型存在担忧,计算能力是本土的相对瓶颈,在A100和H100受限之后,A800/H800成为替代方案,但在算力和训练效率上有有较大折扣。

▪️公司层面:本土AI玩家的主要风险在于地缘zz和芯片禁运,高度依赖国外的开源模型,更为严格的To-C端应用监管。

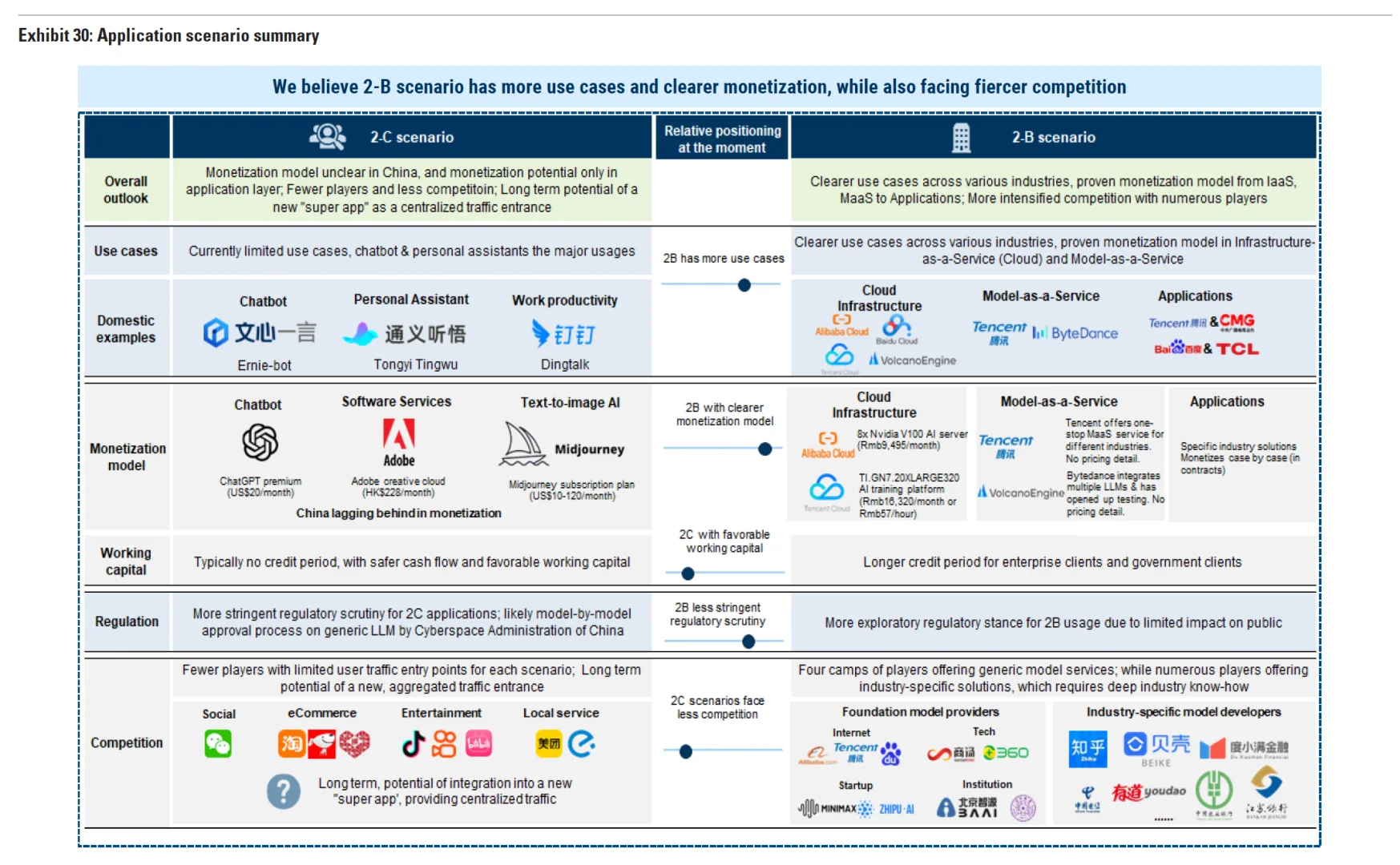

▪️监管因素:本土的大语言模型审批流程是逐个模型进行审批的,这将给面向公众的 C 端场景带来很高的进入壁垒,而面向 B 端的场景面临较少的审查。

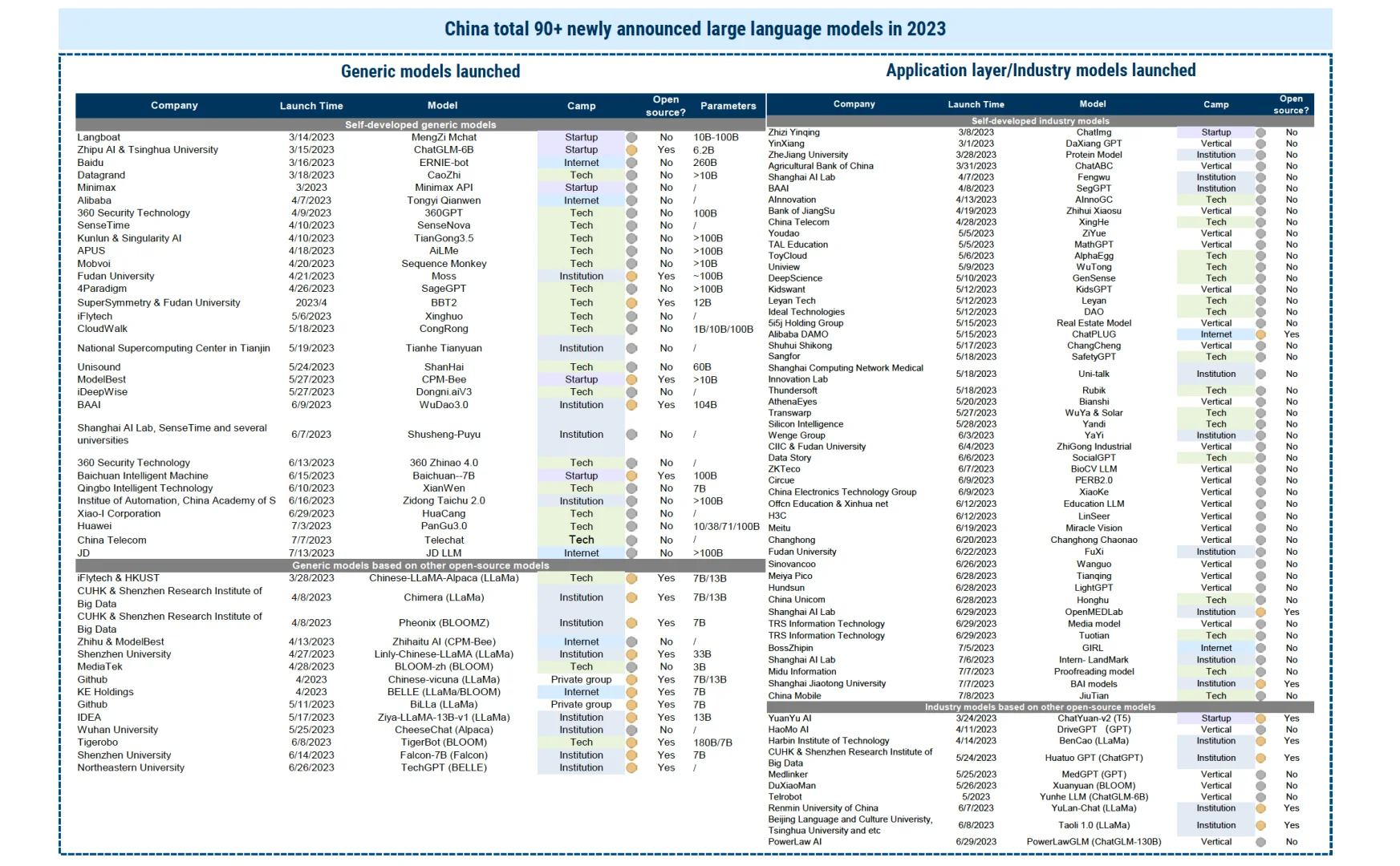

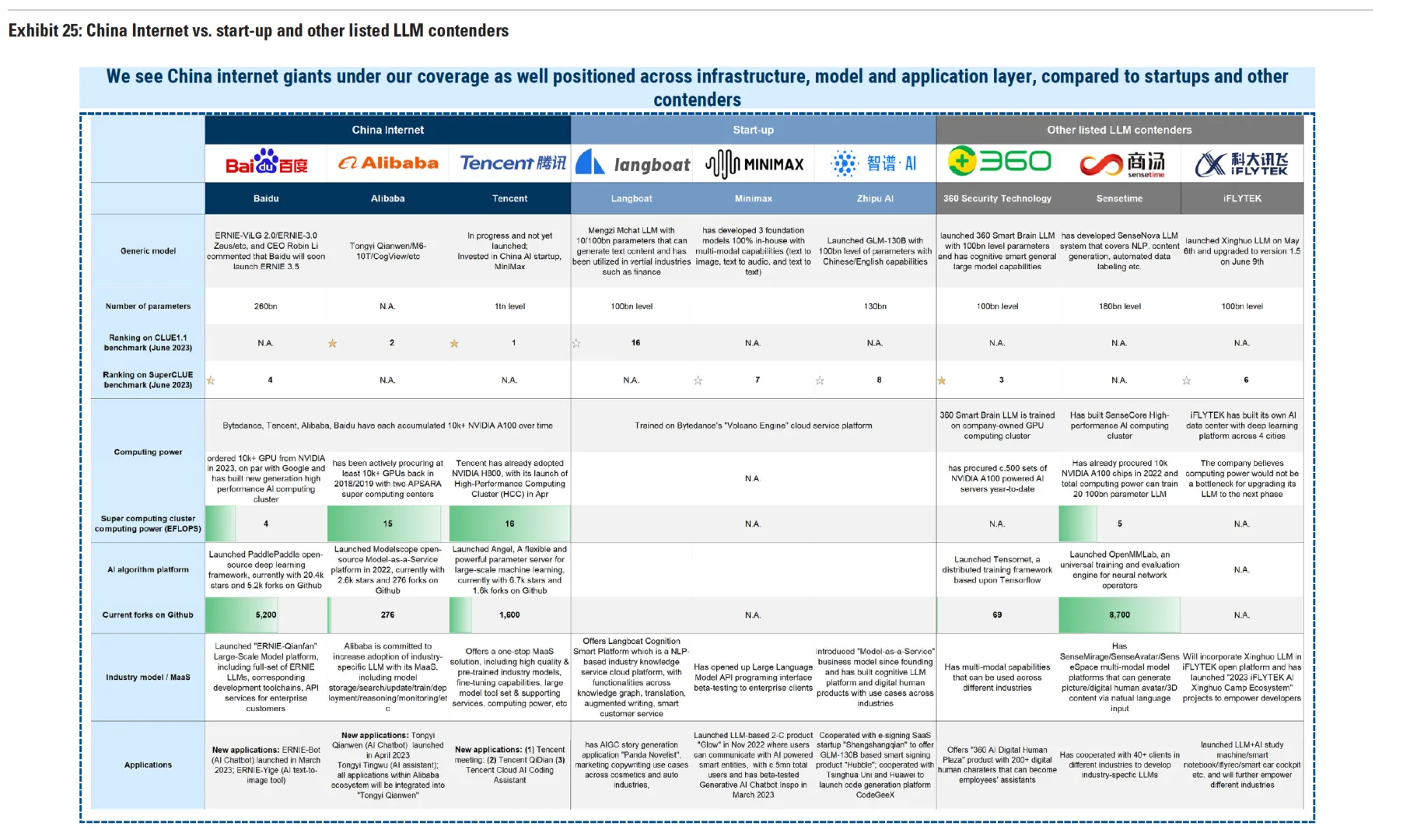

▪️本土算力:本土掌握的算力大致相当50万块A100芯片,字节掌握了最多AI服务器(约10万张A100),相比BAT更加注重模型服务(MaaS),有意愿成为IaaS提供者(训练/微调/推理等),2025年用于推理的GPU超训练用途。

▪️中美比较:中国在AI服务器或GPU、算法和LLM表现、数据(网络仅2%为中文)、和应用场景上(C端付费意愿等)均在追赶,研发人员成本相比美国更有优势。

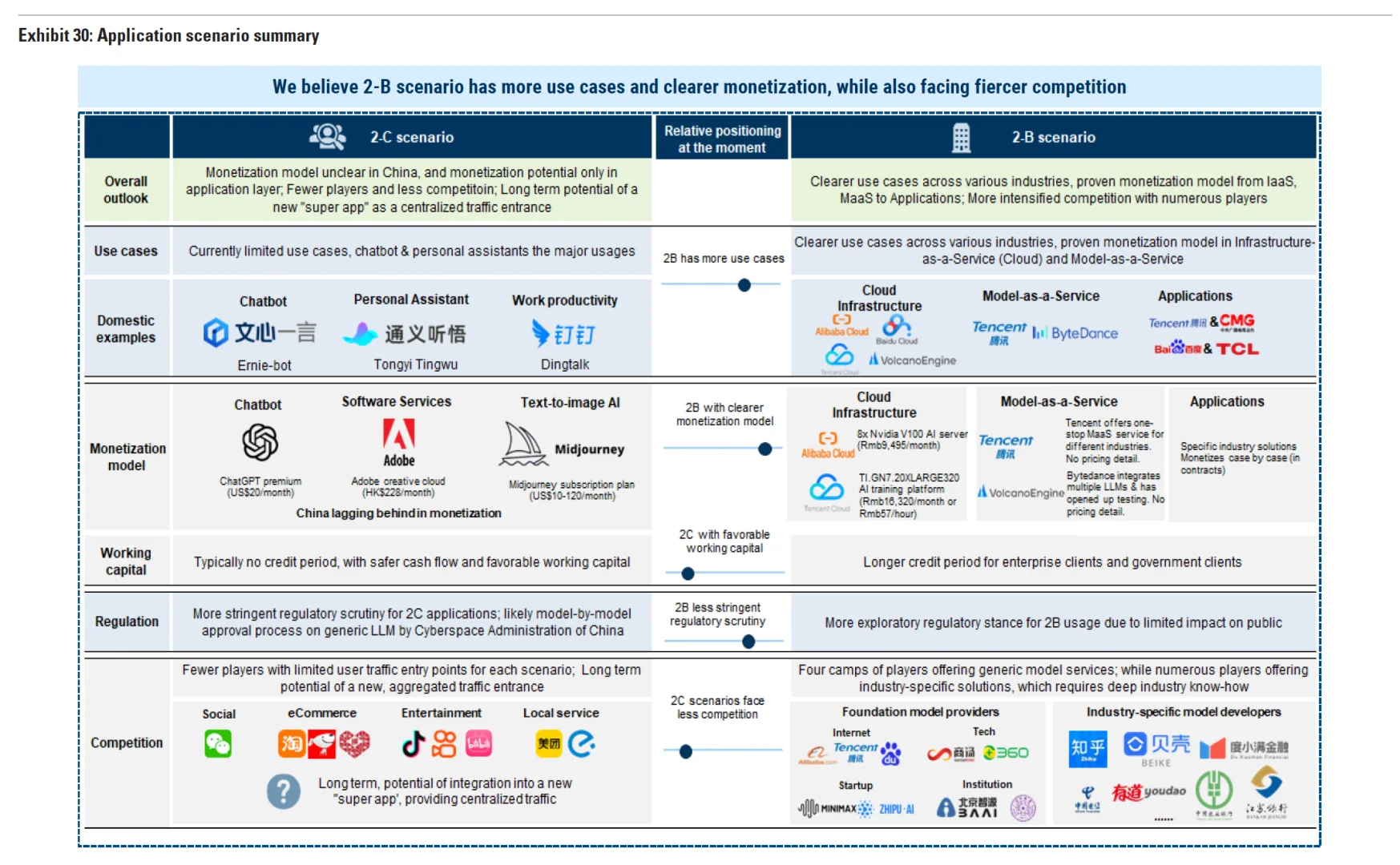

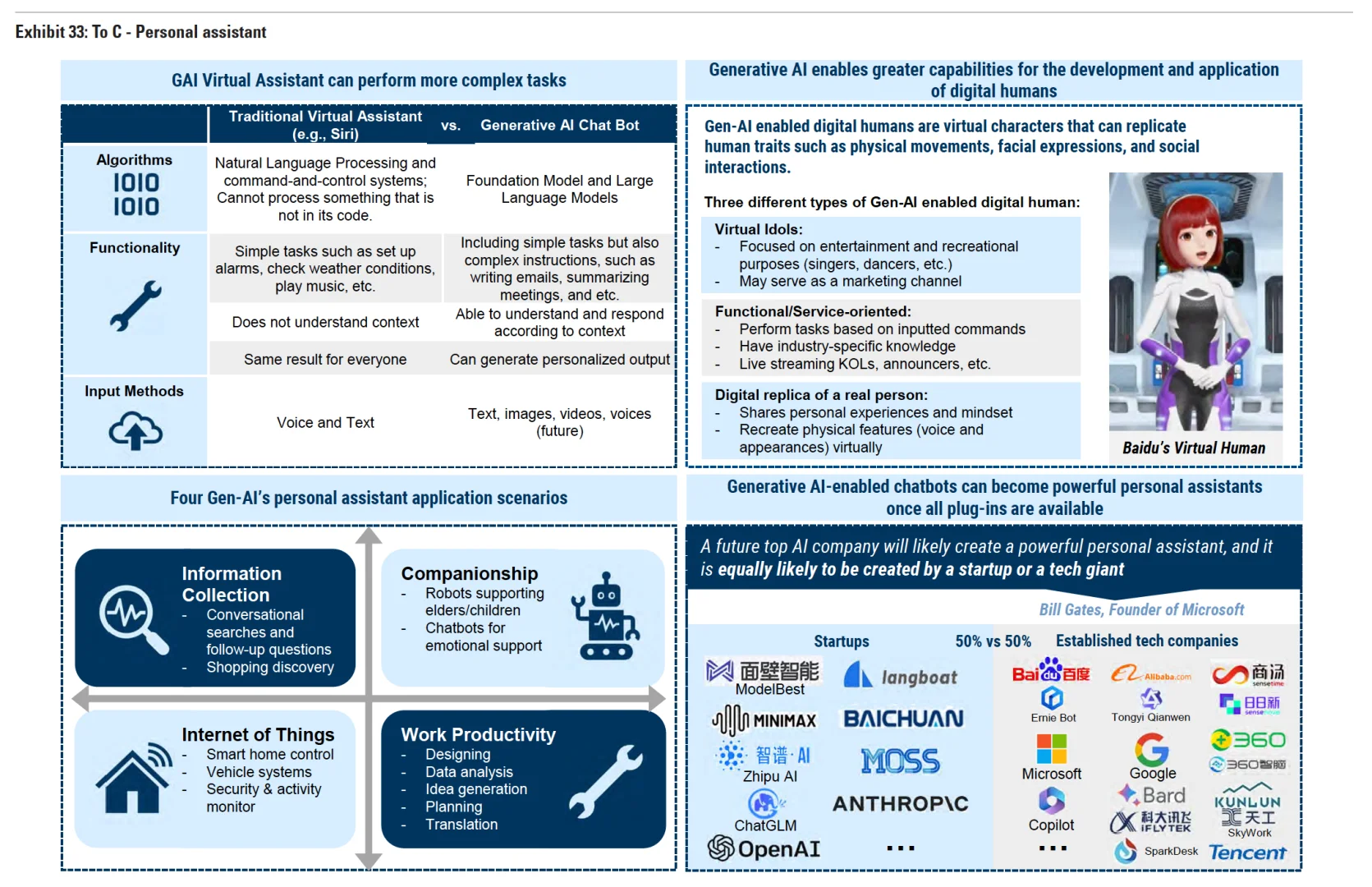

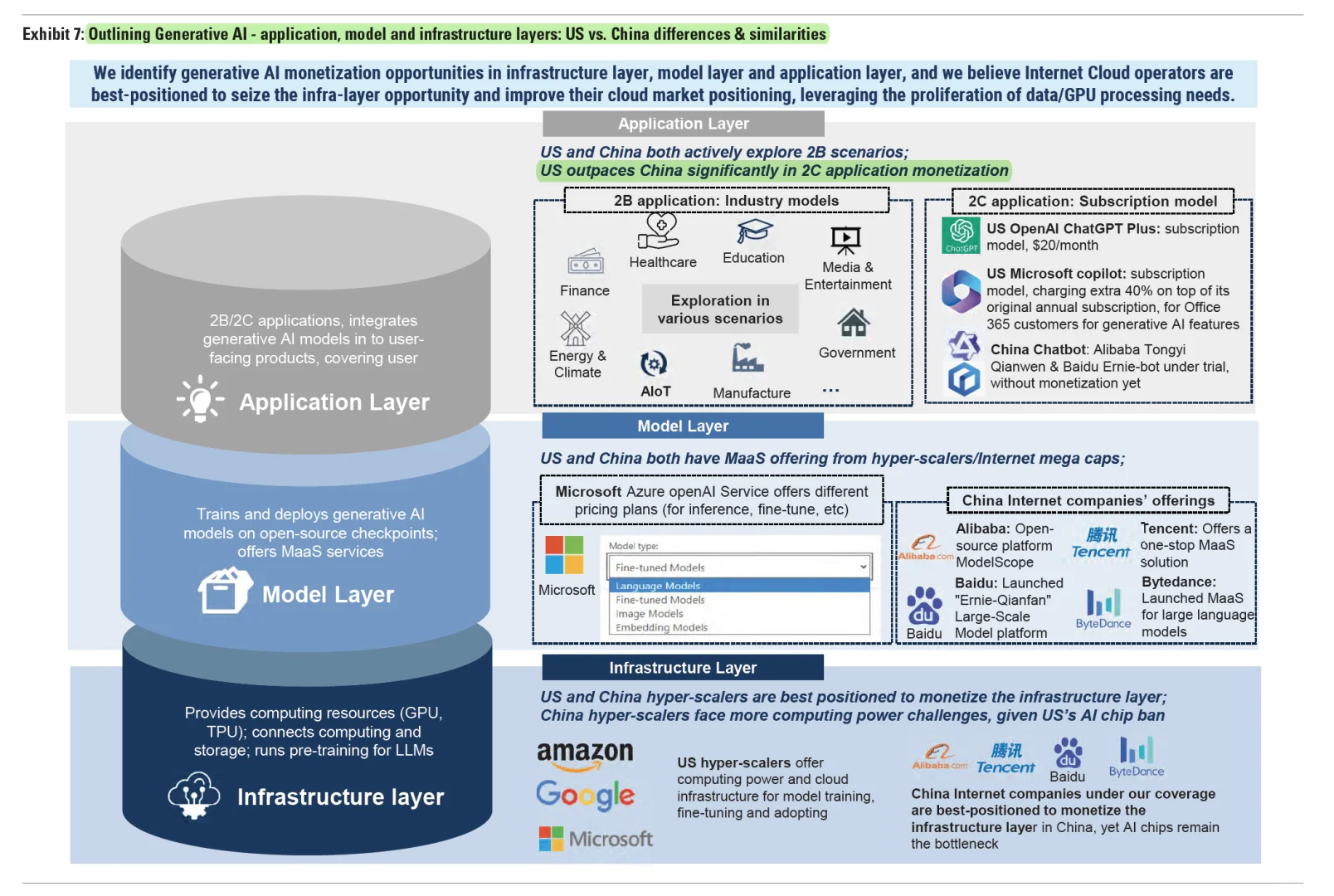

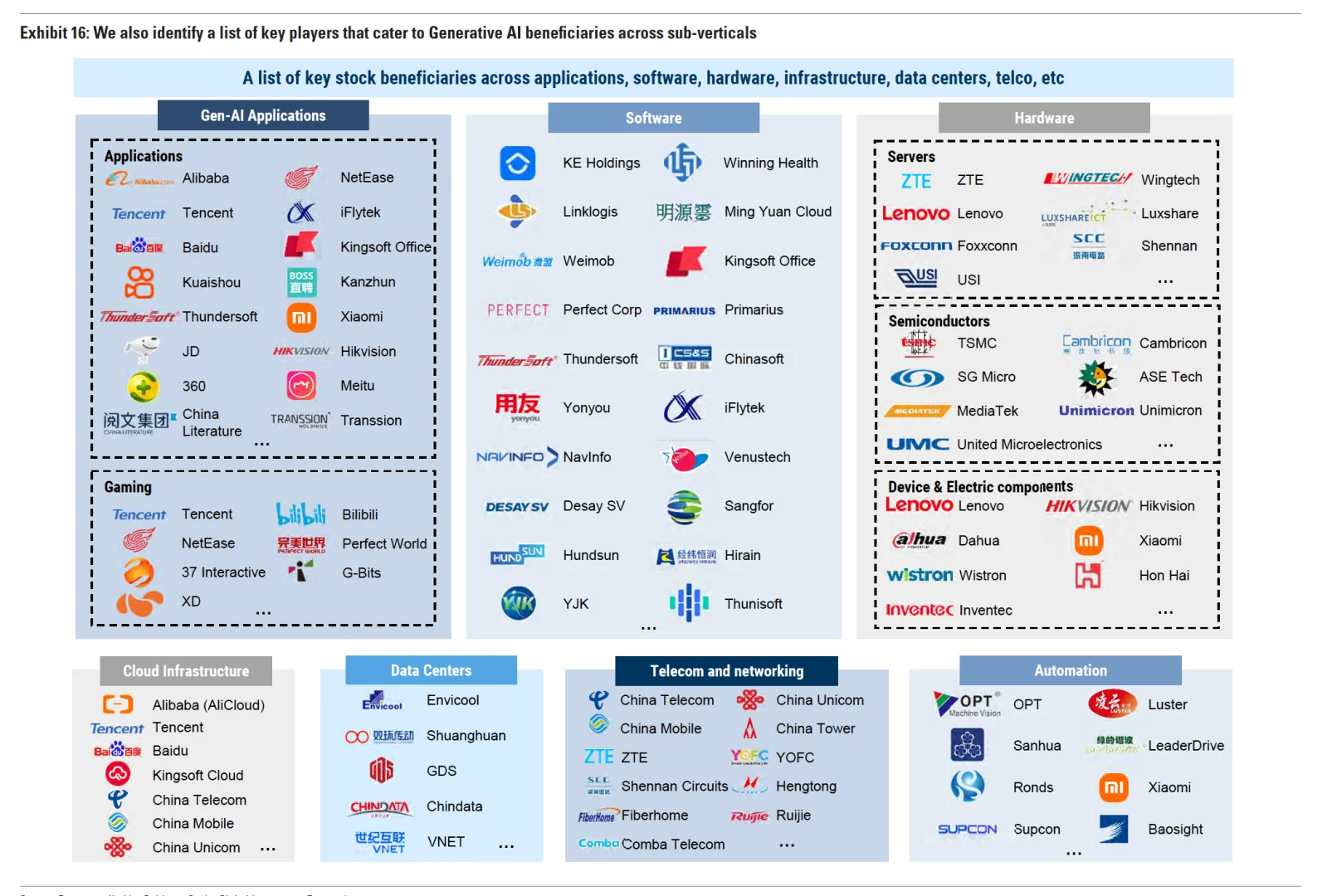

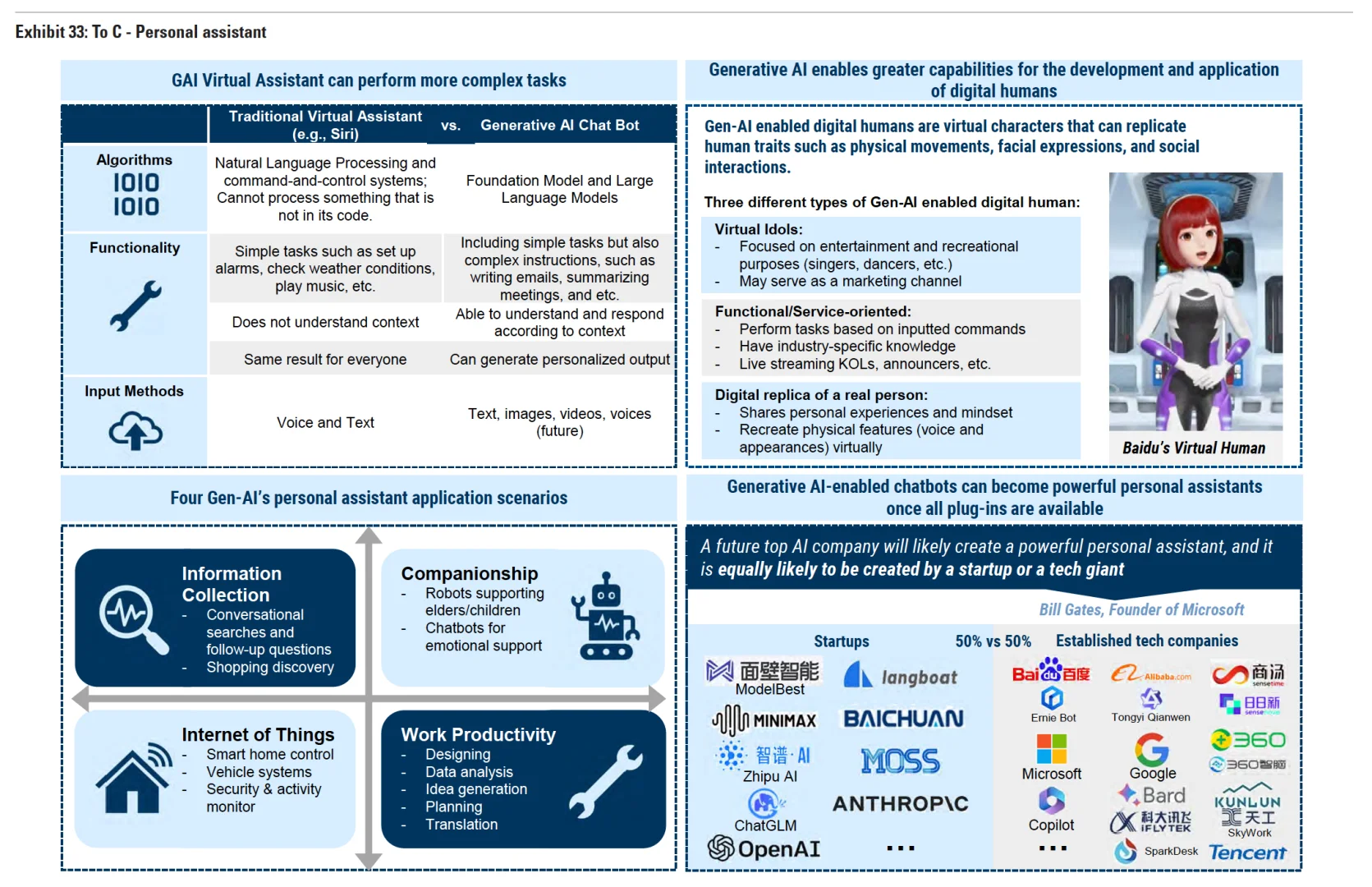

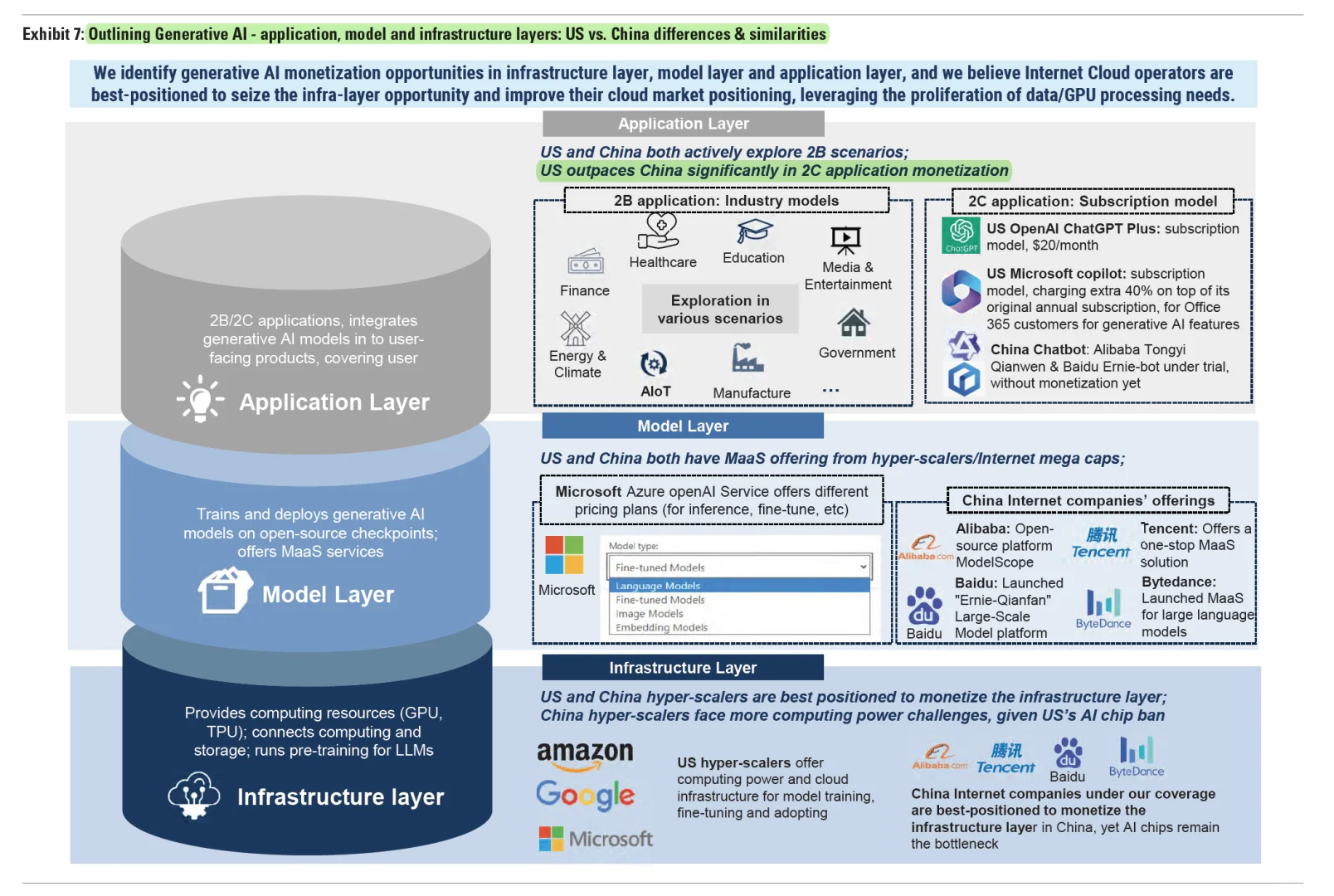

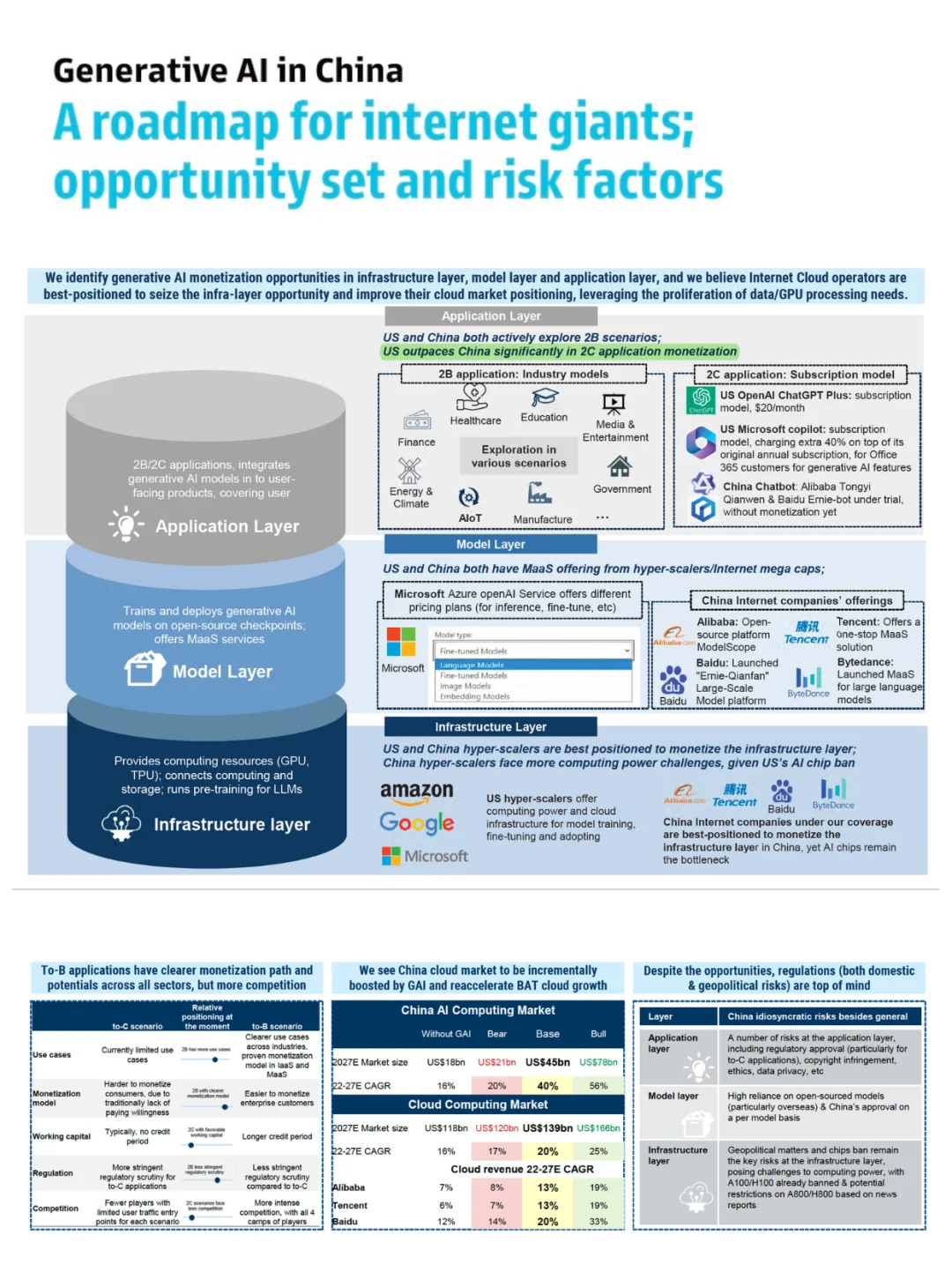

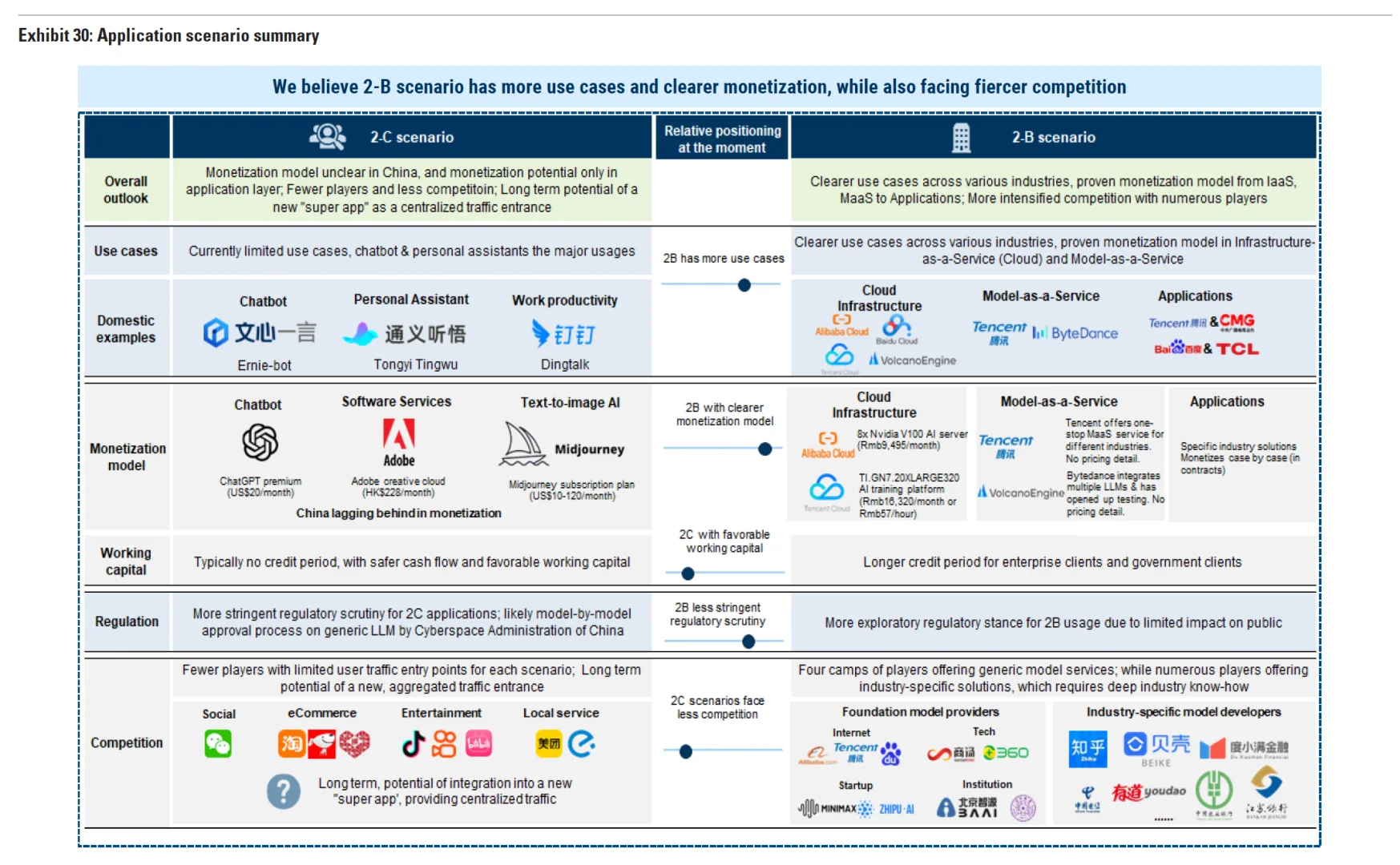

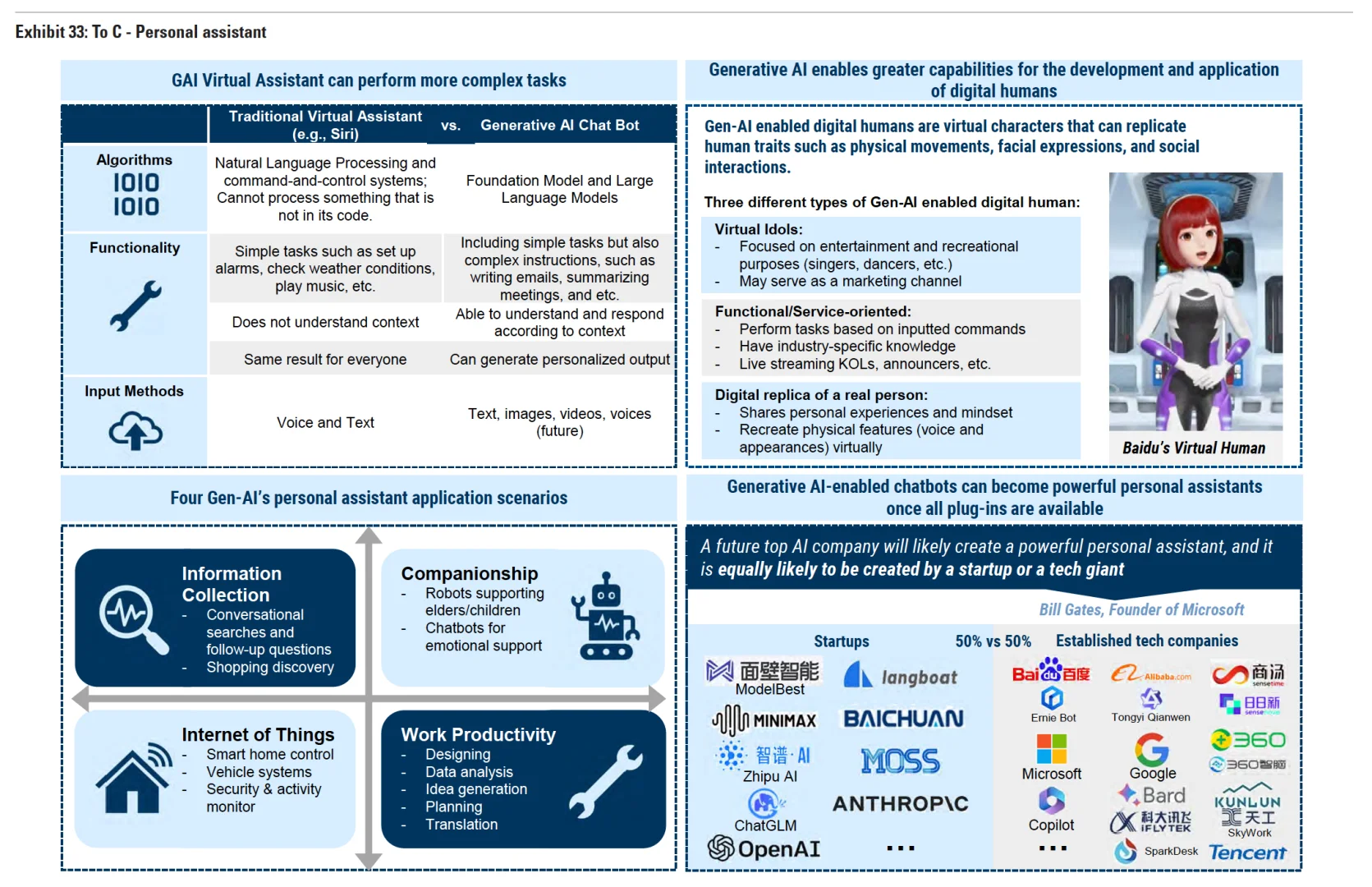

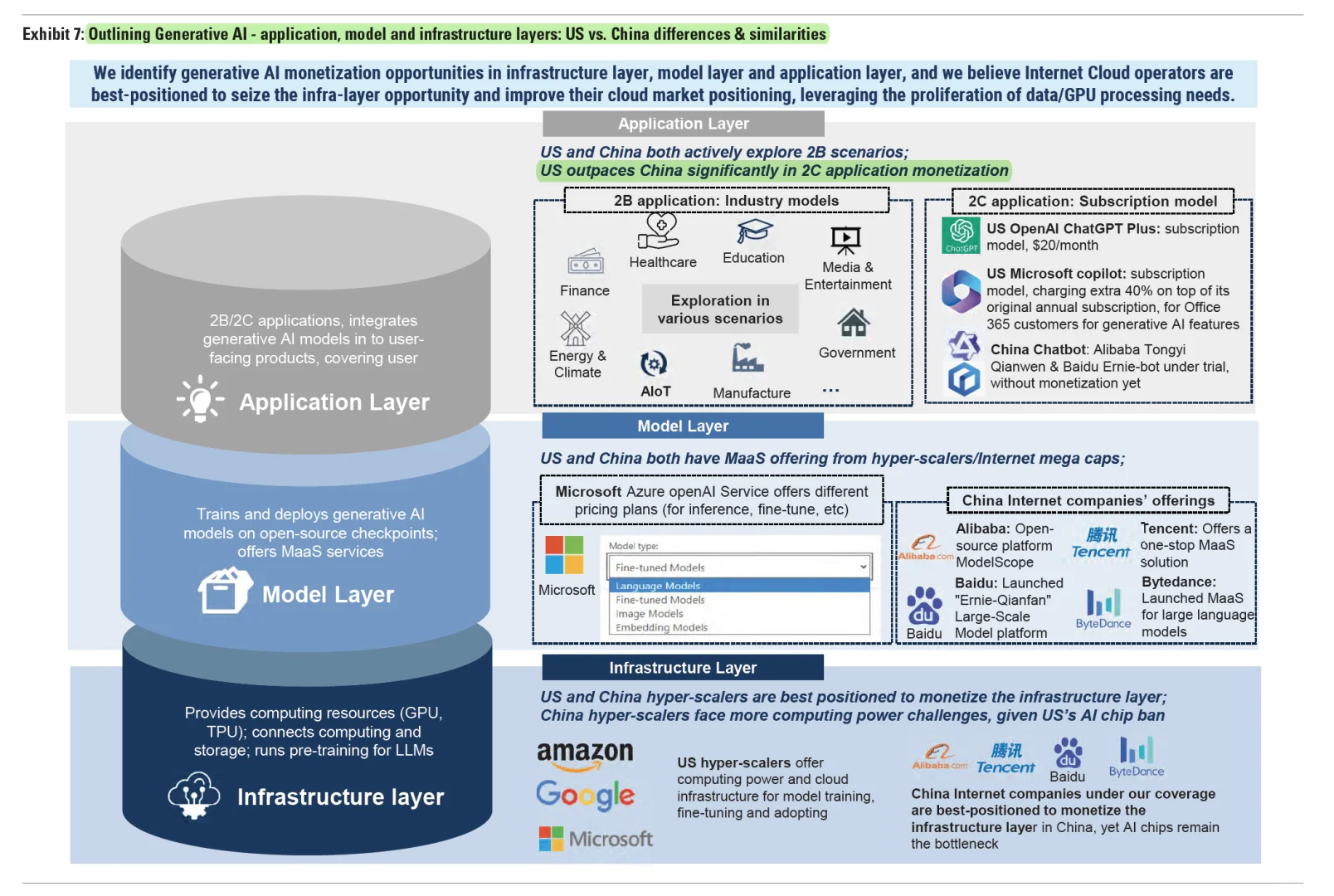

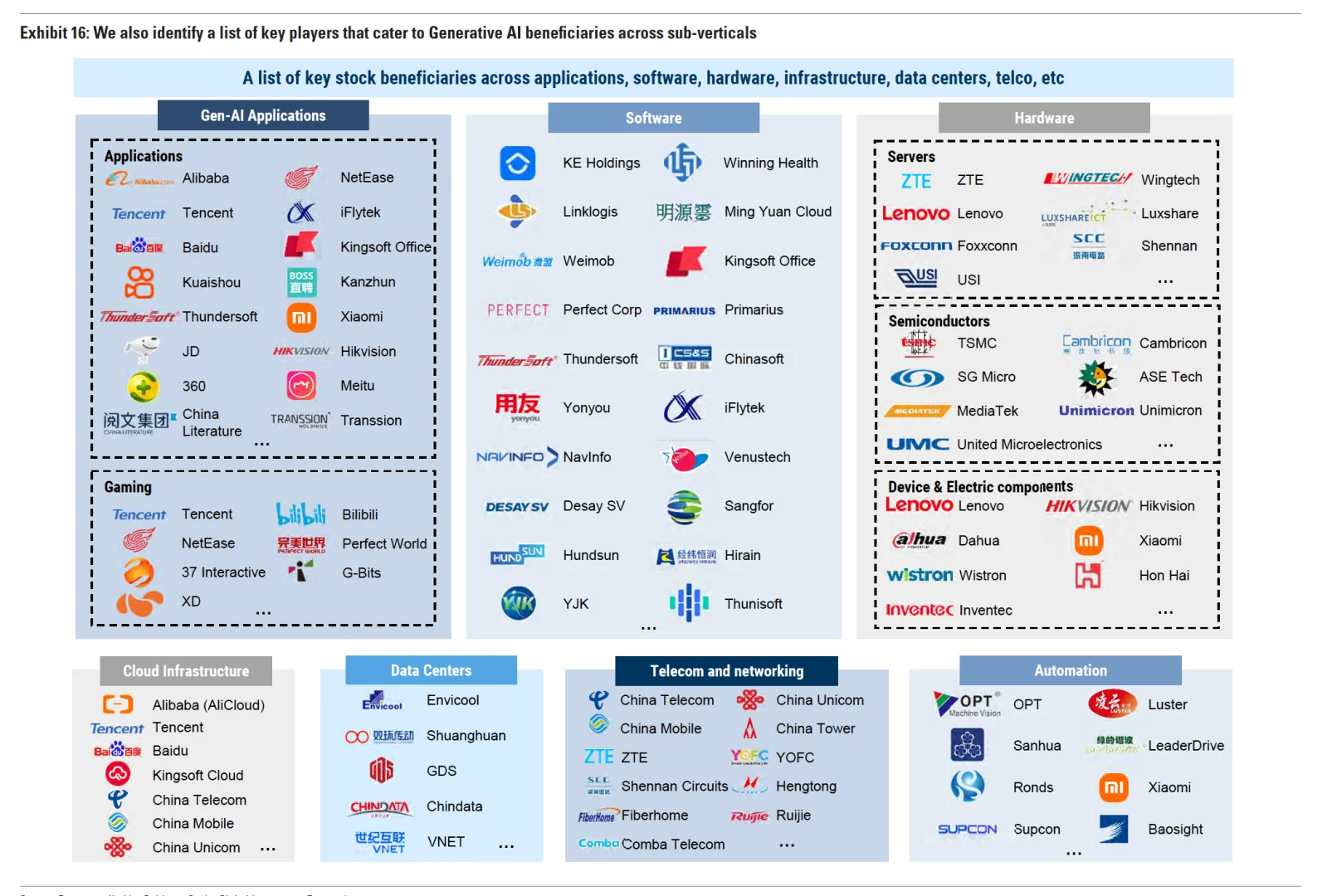

▪️应用层机会:To-B应用有更清晰的变现途径,而To-C尚未验证;B端模式包括云服务(服务器算力租用;MaaS或Token数付费;API集成功能付费;而C端尚不清晰,商业化仍在探索中(chatbox广告/商店开发者收入共享/交易分成等)。

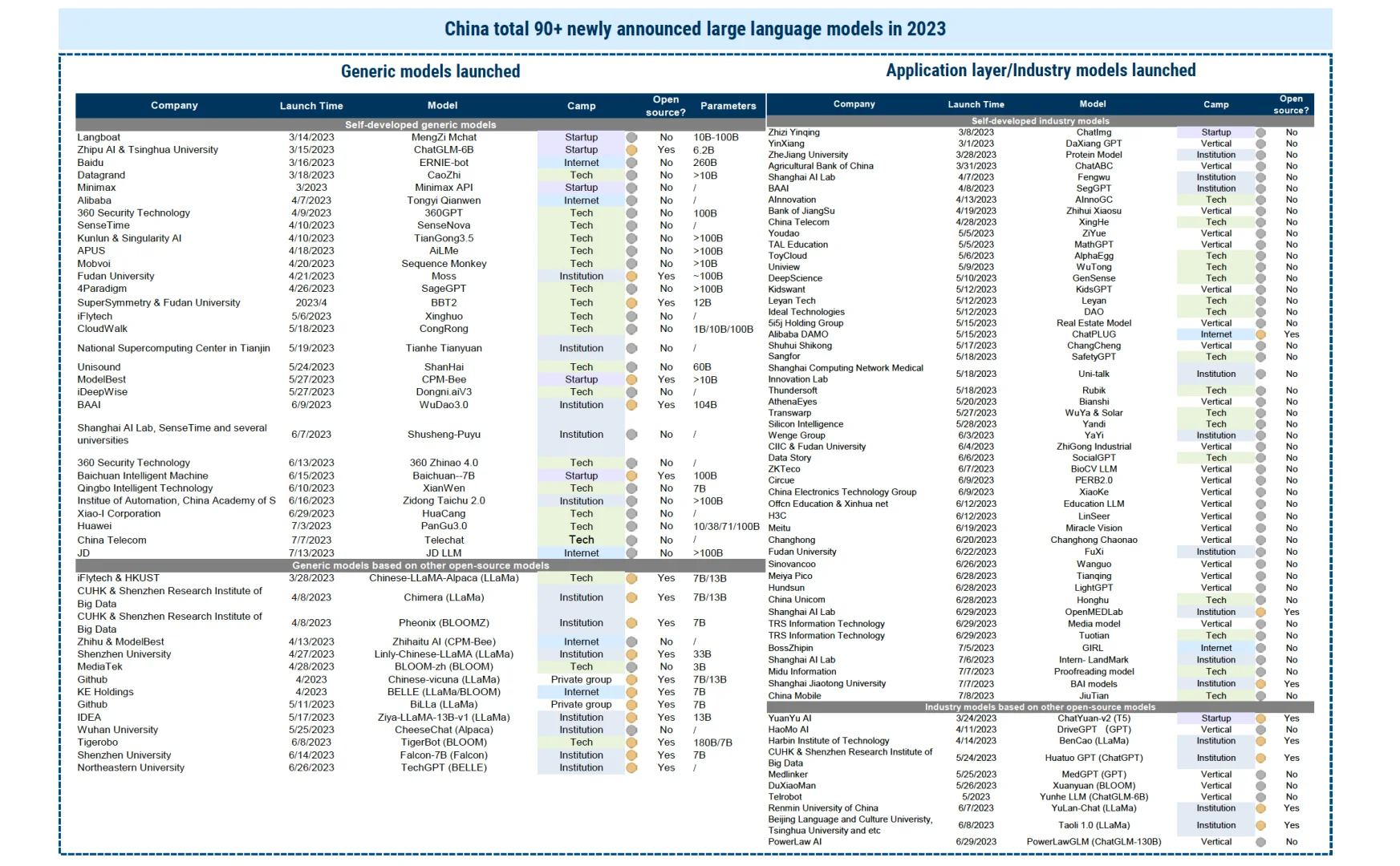

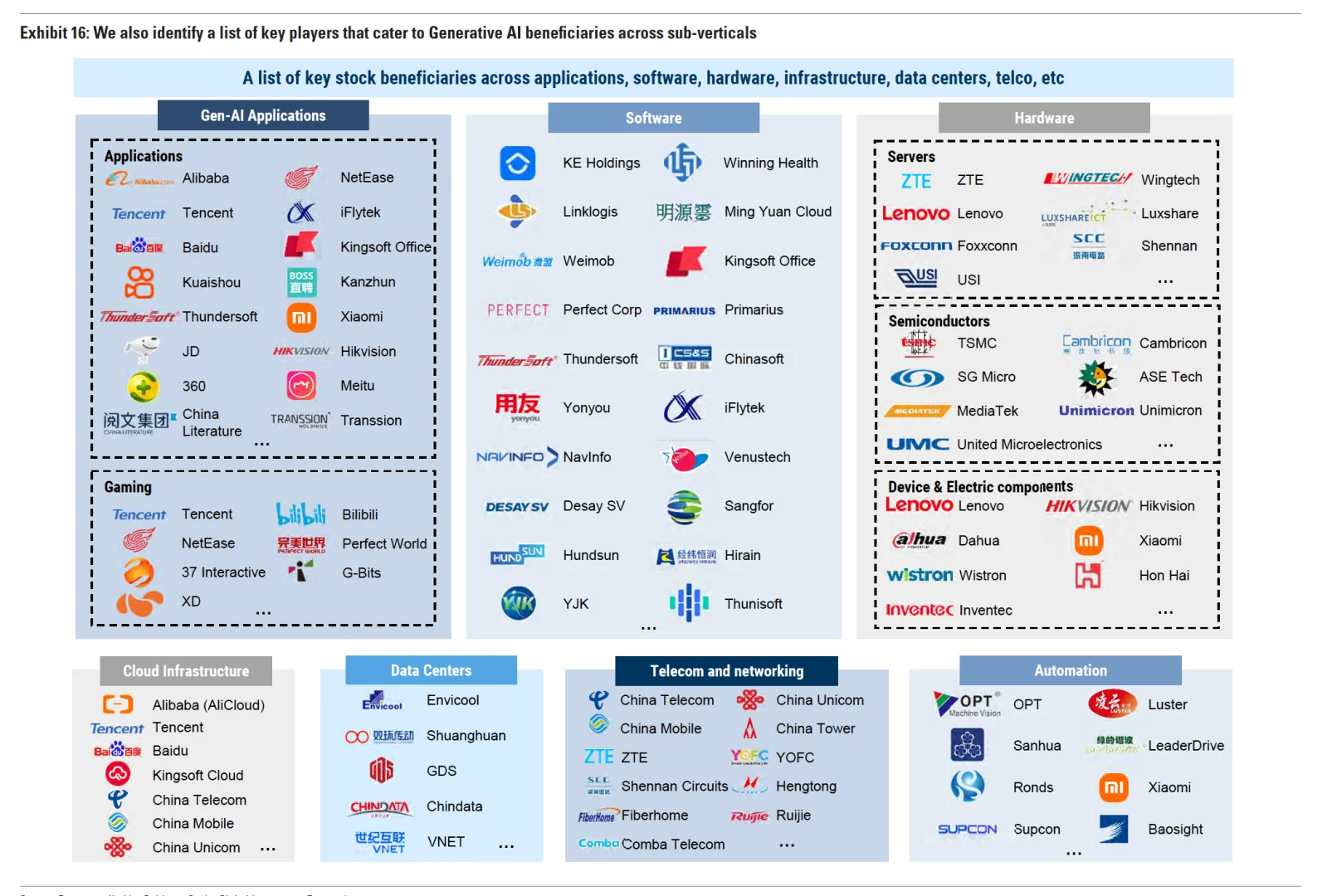

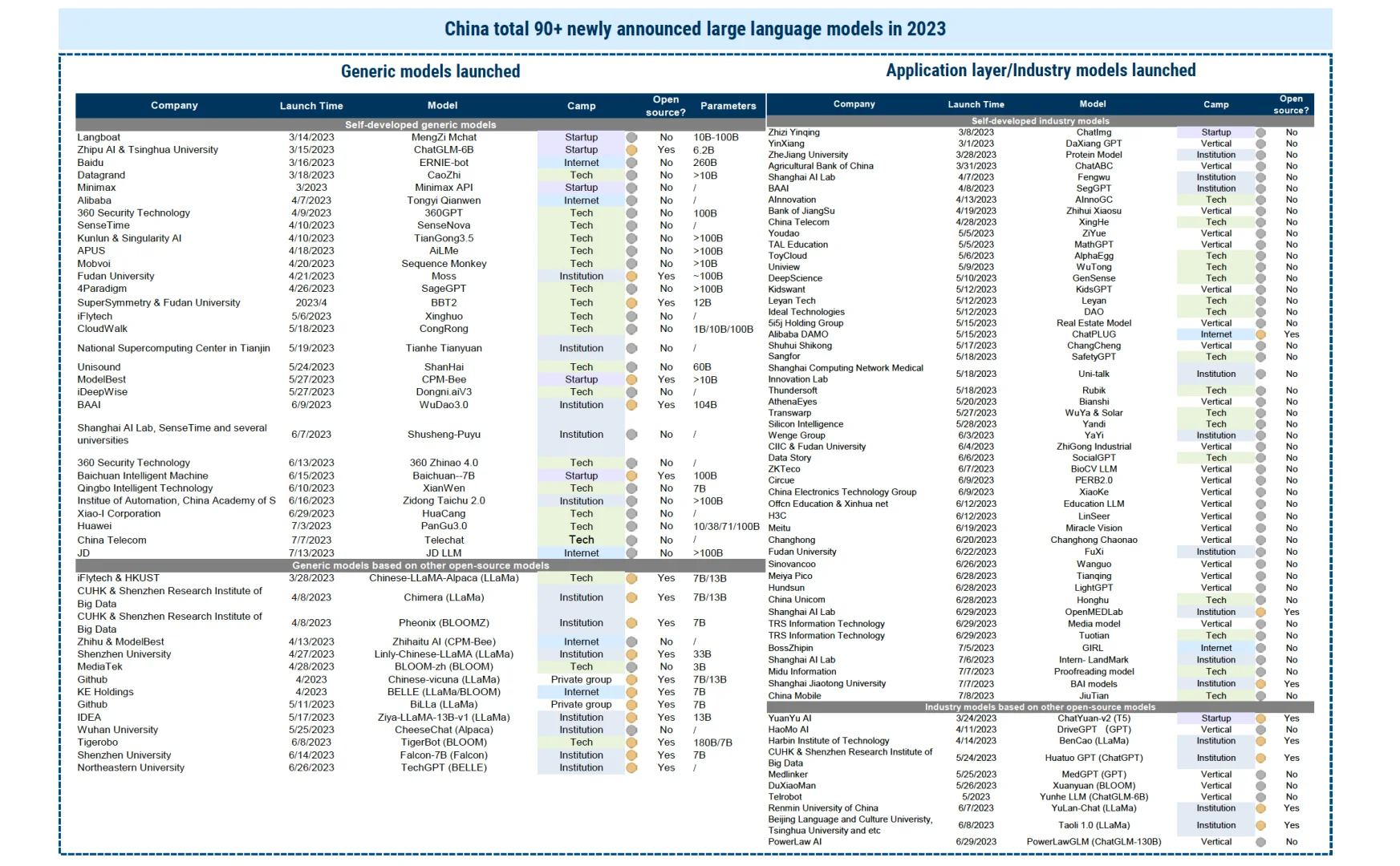

▪️模型层机会:进入模型供给过剩或低ROI,通用模型由少数参与者主导,垂直模型有大量的参与者,巨头的优势在流量来源,LLM可整合到超级应用中,拥有大量私有数据的更有优势。

▪️基础设施层机会:BBAT会占据主导,GPU仍是关键所在,训练和推理依赖于少数本土互联网巨头作为具有MaaS能力的云超大规模提供商。

Varguard

国内这帮傻叉,缺数据不能ai造吗?看看国外吧!没有创新能力就别玩了